- Published on

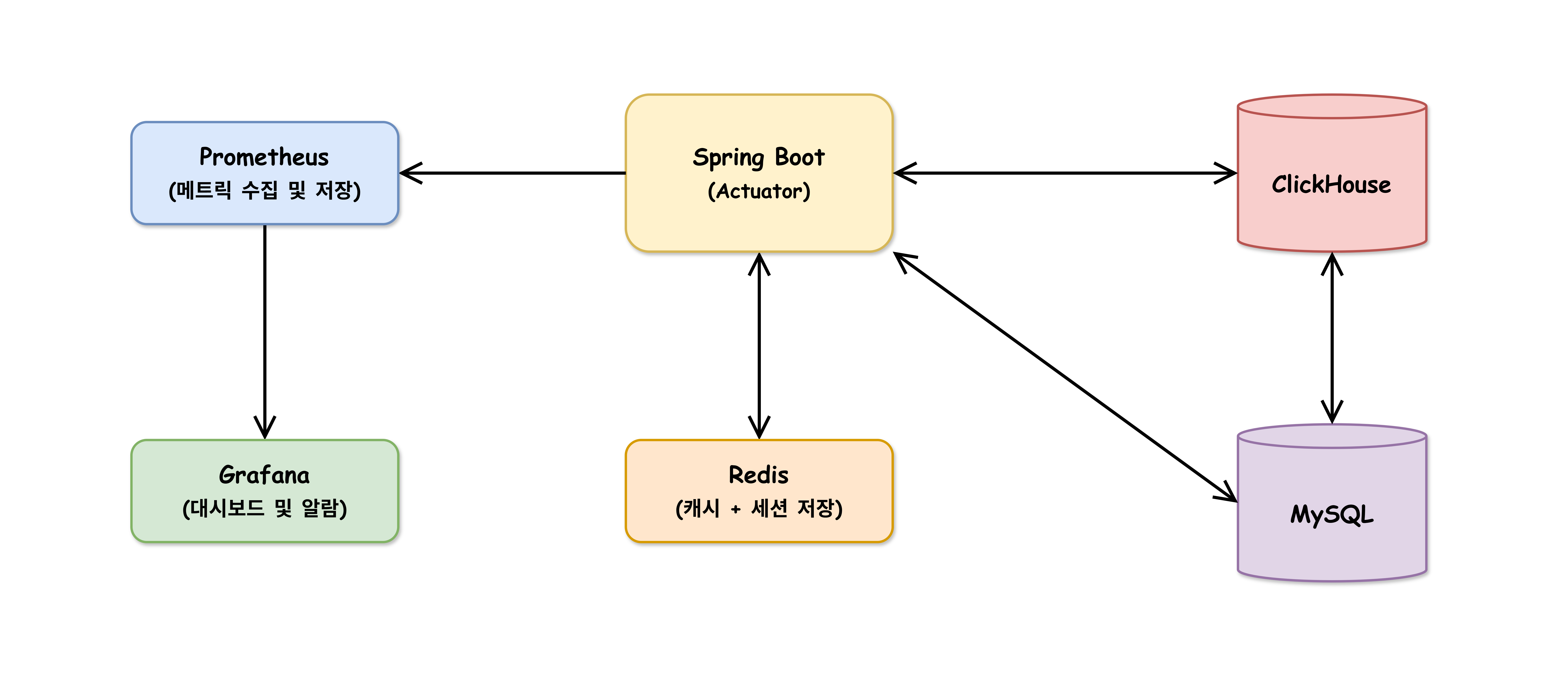

- •👁️

ClickHouse DB

- Authors

- Name

- River

상세 설명

ClickHouse는 원래 Linux 환경을 기준으로 개발되었다. Windows에서 직접 설치하려면 WSL2가 필요하므로, Docker Desktop을 이용하여 Docker로 구성한다.

Docker 환경 준비

Docker 설치 확인

docker --version docker-compose --versionClickHouse 작업 디렉토리 생성

mkdir clickhouse-dev cd clickhouse-dev

docker-compose.yml 구성

services:

clickhouse:

image: clickhouse/clickhouse-server:latest

container_name: clickhouse-server

ports:

- "8123:8123" # HTTP 포트

- "9000:9000" # Native 포트

- "9009:9009" # HTTP/S 포트

volumes:

- clickhouse-data:/var/lib/clickhouse

- ./config:/etc/clickhouse-server/config.d

- ./users:/etc/clickhouse-server/users.d

environment:

CLICKHOUSE_USER: admin

CLICKHOUSE_PASSWORD: 1234

CLICKHOUSE_DEFAULT_ACCESS_MANAGEMENT: 1

ulimits:

nofile:

soft: 262144

hard: 262144

volumes:

clickhouse-data:

볼륨 마운트

clickhouse-data- 이름 있는 볼륨

- ClickHouse 내부 데이터 저장 경로와 연결

./config- 바인드 마운트

- 직접 만든 커스텀 설정 파일(

custom.xml등)을 넣을 디렉토리

./users- 바인드 마운트

- 직접 만든 커스텀 사용자 파일(

dev-user.xml등)을 넣을 디렉토리

ClickHouse 내부 폴더 구조

/var/lib/clickhouse- ClickHouse의 고정된 데이터 저장 경로

/etc/clickhouse-server- config.xml - 모든 기본 설정을 담고 있는 메인 설정 파일

- users.xml - 모든 기본 사용자를 담고 있는 메인 사용자 파일

/etc/clickhouse-server/config.d- 직접 만든

./config폴더가 여기에 연결 custom.xml로 config.xml의 내용을 덮어쓰거나 추가

- 직접 만든

/etc/clickhouse-server/users.d- 직접 만든

./users폴더가 여기에 연결 dev-userxml.xml로 users.xml의 내용을 덮어쓰거나 추가

- 직접 만든

ClickHouse 기본 포트

8123(HTTP) - DBeaver 같은 GUI 툴, REST API 요청 등9000(Native TCP) - 성능이 가장 좋다. 클라이언트 연결용8443(HTTPS)9440(Secure Native TCP)

CLICKHOUSE_DEFAULT_ACCESS_MANAGEMENT: 1

1(켜기) 또는0(끄기)- 사용자의 권한과 비밀번호를 세밀하게 관리하는 기능을 활성화

ulimits 설정

- 동시에 열 수 있는 파일의 최대 개수를 늘려주는 옵션

- MergeTree 엔진에서 수백, 수천 개의 파일을 동시에 열어서 작업해야 하는데, 설정하지 않는다면 최대 개수를 낮게 설정하여 "Too many open files" 오류 발생

- 2의 18승으로 충분히 크고 안전하게 설정

컨테이너 구성 시작과 접속 확인

커스텀 config 설정

문서에서 “The default Clickhouse listen_host is 127.0.0.1”라는 언급

공식 Docker 이미지에서 아래를 설정한다.

<listen_host>0.0.0.0</listen_host> <!-- IPv4 모든 주소 -->clickhouse-dev/config/custom.xml생성<?xml version="1.0"?> <clickhouse> <listen_host>0.0.0.0</listen_host> </clickhouse>- 기본 접속은 localhost 접속이 허용되지만, Docker Container의 localhost와 로컬 PC의 localhost는 같지 않다.

- 이렇게 네트워크 바인딩을 설정해야 외부 접속이 가능하다.

ClickHouse 컨테이너 시작

docker-compose up -d- 상태 확인 :

docker-compose ps

- 상태 확인 :

ClickHouse 로그 확인

docker-compose logs clickhouse설정 파일 확인

- 파일 확인

docker exec clickhouse-server ls -la /etc/clickhouse-server/config.d/docker exec clickhouse-server cat /etc/clickhouse-server/config.d/test.xml

- 설정 적용 확인

docker exec clickhouse-server netstat -tln | grep 8123

- 파일 확인

연결 테스트

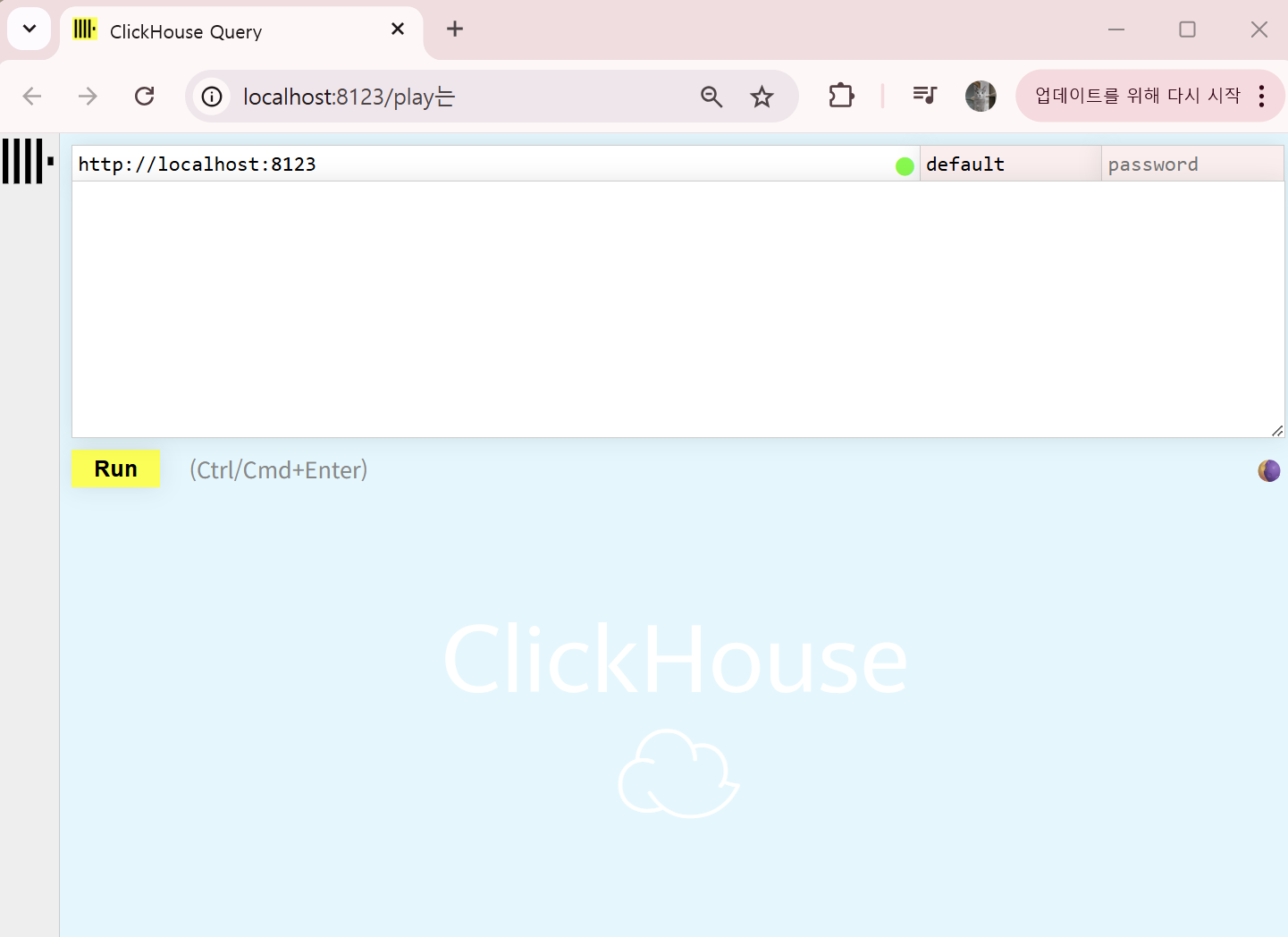

# 현재 버전 확인 curl -u admin:1234 'http://localhost:8123/?query=SELECT%20version()' # 현재 사용자 확인 curl -u admin:1234 'http://localhost:8123/?query=SELECT%20user()' # 데이터베이스 목록 curl -u admin:1234 'http://localhost:8123/?query=SHOW%20DATABASES' # 직접 접속 docker exec -it clickhouse-server clickhouse-client --user admin --password 1234- 브라우저 :

http://localhost:8123접속

- 브라우저 :

ClickHouse 연결 생성

새 연결 생성

연결 정보 설정

- Server Host : localhost

- Port : 8123

- Username : admin

- Password : 1234

- URL : jdbc:clickhouse://localhost:8123

Driver properties 탭에서 추가 설정

compress: true # 압축 활성화 max_execution_time: 300 # 쿼리 타임아웃 (초)compress: true- 네트워크 트래픽 압축으로 대용량 데이터 전송 시 속도 향상

max_execution_time: 300- 쿼리 타임 아웃으로 무한 대기 방지

연결 테스트

DBeaver에서 기본 쿼리 실행

버전 확인

SELECT version();데이터베이스 목록 확인

SHOW DATABASES;현재 사용자 정보

SELECT user(), currentDatabase();메모리 사용 정보 확인

SELECT (SELECT formatReadableSize(value) FROM system.asynchronous_metrics WHERE metric = 'MemoryResident') AS "프로세스 실제 사용량", (SELECT formatReadableSize(value) FROM system.asynchronous_metrics WHERE metric = 'TrackedMemory') AS "쿼리 사용량", (SELECT formatReadableSize(value) FROM system.asynchronous_metrics WHERE metric = 'CGroupMemoryUsed') AS "컨테이너 사용량", (SELECT formatReadableSize(value) FROM system.asynchronous_metrics WHERE metric = 'OSMemoryAvailable') AS "OS 여유 메모리" FROM system.one;

데이터베이스 생성

-- 의료 데이터 전용 데이터베이스 생성 CREATE DATABASE medical; -- 데이터베이스 사용 USE medical; -- 생성된 데이터베이스 확인 SHOW DATABASES;환자 기본정보 테이블

CREATE TABLE patients ( patient_id String, name String, birth_date Date, gender Enum8('M' = 1, 'F' = 2), phone String, email String, address String, registration_date DateTime DEFAULT now(), is_active UInt8 DEFAULT 1 ) ENGINE = MergeTree() ORDER BY patient_id PARTITION BY toYYYYMM(registration_date) COMMENT '환자 기본정보 테이블';테이블 설계 특징

patient_id: 환자 고유 식별자 (ORDER BY로 기본 정렬)Enum8: 성별을 숫자로 저장하여 압축 효율성 증대PARTITION BY: 등록월별 파티셔닝으로 쿼리 성능 향상MergeTree(): 압축 알고리즘 자동 적용

자동 압축의 원리

- ClickHouse의 MergeTree 계열 엔진은 데이터를 저장할 때, 서버 설정에 지정된 기본 압축 코덱(Default Codec)을 모든 컬럼에 자동으로 적용

- 이 기본 코덱은 일반적으로 압축 및 해제 속도가 매우 빠른 LZ4로 설정되어 있다.

진료기록 테이블

CREATE TABLE medical_records ( record_id String, patient_id String, visit_date DateTime, department String, doctor_name String, diagnosis_code String, -- ICD-10 코드 diagnosis_name String, symptoms Array(String), -- 증상 배열 treatment_plan Text, prescription Array(String), -- 처방약 배열 visit_type Enum8('OUTPATIENT' = 1, 'INPATIENT' = 2, 'EMERGENCY' = 3), cost Decimal(10,2), insurance_coverage Decimal(10,2), created_at DateTime DEFAULT now() ) ENGINE = MergeTree() ORDER BY (patient_id, visit_date) PARTITION BY toYYYYMM(visit_date) COMMENT '환자 진료기록 테이블';- Columnar DB 장점 활용

Array(String): 증상과 처방을 배열로 저장 (벡터화 처리 최적화)ORDER BY (patient_id, visit_date): 환자별 시계열 조회 최적화Decimal: 금액 데이터의 정확한 계산- 같은

PARTITION BY전략으로 날짜 범위 쿼리 효율화

- Columnar DB 장점 활용

샘플 데이터 INSERT

-- 환자 데이터 삽입 INSERT INTO patients VALUES ('P001', '김철수', '1985-03-15', 'M', '010-1234-5678', 'kim@email.com', '서울시 강남구', '2024-01-15 09:30:00', 1), ('P002', '이영희', '1990-07-22', 'F', '010-2345-6789', 'lee@email.com', '서울시 서초구', '2024-01-16 10:15:00', 1), ('P003', '박민수', '1978-11-08', 'M', '010-3456-7890', 'park@email.com', '경기도 성남시', '2024-01-17 14:20:00', 1), ('P004', '최지영', '1995-05-30', 'F', '010-4567-8901', 'choi@email.com', '서울시 송파구', '2024-02-01 11:45:00', 1), ('P005', '정대호', '1982-09-12', 'M', '010-5678-9012', 'jung@email.com', '인천시 남동구', '2024-02-03 16:30:00', 1); -- 진료기록 데이터 삽입 INSERT INTO medical_records VALUES ('R001', 'P001', '2024-02-01 09:00:00', '내과', '홍길동', 'K25.9', '위궤양', ['복통', '소화불량'], '약물치료 및 식단조절', ['오메프라졸', '돔페리돈'], 'OUTPATIENT', 45000.00, 31500.00, now()), ('R002', 'P002', '2024-02-01 14:30:00', '산부인과', '김영희', 'Z34.9', '임신관리', ['임신 증상'], '정기검진 및 영양제 복용', ['엽산', '철분제'], 'OUTPATIENT', 85000.00, 59500.00, now()), ('R003', 'P003', '2024-02-02 10:15:00', '정형외과', '박정수', 'M25.5', '관절통', ['무릎 통증', '부종'], '물리치료 및 진통제', ['이부프로펜', '근육이완제'], 'OUTPATIENT', 120000.00, 84000.00, now()), ('R004', 'P001', '2024-02-15 11:00:00', '내과', '홍길동', 'K25.9', '위궤양 추적관찰', ['호전된 상태'], '약물치료 지속', ['오메프라졸'], 'OUTPATIENT', 25000.00, 17500.00, now()), ('R005', 'P004', '2024-02-20 15:45:00', '응급의학과', '응급실의사', 'R50.9', '발열', ['고열', '오한', '두통'], '해열제 투여 및 관찰', ['아세트아미노펜'], 'EMERGENCY', 180000.00, 126000.00, now());

전체 환자 수 확인

SELECT COUNT(*) as total_patients FROM patients;- 결과

total_patients= 5

- 결과

성별 분포 확인

SELECT gender, COUNT(*) as count FROM patients GROUP BY gender;- 결과

gender count M 3 F 2

- 결과

월별 등록 환자 수

SELECT toYYYYMM(registration_date) as month, COUNT(*) as new_patients FROM patients GROUP BY month ORDER BY month;- ClickHouse 전용 함수

toYYYYMM()

- 결과

month new_patients 202401 3 202402 2

- ClickHouse 전용 함수

환자별 진료 이력 조회

SELECT p.name, mr.visit_date, mr.department, mr.diagnosis_name, mr.cost FROM patients p JOIN medical_records mr ON p.patient_id = mr.patient_id ORDER BY p.patient_id, mr.visit_date;- 결과

name visit_date department diagnosis_name cost 김철수 2024-02-01 09:00:00 내과 위궤양 45000.00 김철수 2024-02-15 11:00:00 내과 위궤양 추적관찰 25000.00 이영희 2024-02-01 14:30:00 산부인과 임신관리 85000.00 박민수 2024-02-02 10:15:00 정형외과 관절통 120000.00 최지영 2024-02-20 15:45:00 응급의학과 발열 180000.00

- 결과

부서별 매출 통계

SELECT department, COUNT(*) as visit_count, SUM(cost) as total_revenue, AVG(cost) as avg_cost, formatReadableSize(SUM(cost)) as readable_revenue FROM medical_records GROUP BY department ORDER BY total_revenue DESC;- ClickHouse 전용 함수

formatReadableSize()- 바이트를 KB/MB로 변환

- Columnar DB 집계의 장점은 속도

- 모든 행을 읽어서 필요한 컬럼만 추출하는 Row-based DB와 달리 필요한 컬럼만 바로 읽어서 계산한다.

- 결과

department visit_count total_revenue avg_cost readable_revenue 응급의학과 1 180000.00 180000.0 175.78 KiB 정형외과 1 120000.00 120000.0 117.19 KiB 산부인과 1 85000.00 85000.0 83.01 KiB 내과 2 70000.00 35000.0 68.36 KiB

- ClickHouse 전용 함수

배열 데이터 조회

SELECT patient_id, diagnosis_name, symptoms, arrayStringConcat(symptoms, ', ') as symptoms_text, length(prescription) as prescription_count FROM medical_records WHERE has(symptoms, '복통'); -- '복통' 증상이 있는 환자- ClickHouse 전용 함수

arrayStringConcat()- 배열 전용 함수has(symptoms, '복통')- 배열에서 특정 값 검색

- 결과

patient_id diagnosis_name symptoms symptoms_text prescription_count P001 위궤양 ['복통','소화불량'] 복통, 소화불량 2

- ClickHouse 전용 함수

ClickHouse의 MergeTree 엔진

- MergeTree 엔진은 데이터를 하나의 거대한 파일이 아닌, 여러 개의 작은 조각(Data Part)으로 나누어 저장한다.

INSERT를 할 때마다 새로운 데이터 파트가 생성되고, ClickHouse 백그라운드에서 이 작은 파트들을 더 큰 파트로 계속 병합하며 최적화한다.- system.parts 테이블은 모든 데이터 파트들의 목록과 상세 정보가 담겨있다.

Columnar DB 압축 효과 테스트

테이블 크기와 압축률 확인

SELECT table, formatReadableSize(sum(bytes_on_disk)) as compressed_size, formatReadableSize(sum(data_uncompressed_bytes)) as uncompressed_size, round(sum(data_uncompressed_bytes) / sum(bytes_on_disk), 2) as compression_ratio FROM system.parts WHERE database = 'medical' GROUP BY table;- medical 데이터베이스의 각 테이블이 디스크에서 얼마나 공간을 차지하는지, 압축률이 얼마나 되는지 보여준다.

- 동작 원리

FROM system.parts WHERE database = 'medical'- 모든 데이터 파트 목록 및 정보를 가져와서

medical만 필터링

- 모든 데이터 파트 목록 및 정보를 가져와서

GROUP BY tablepatients테이블용,medical_records테이블용으로 각각 그룹화

formatReadableSize()- Byte 단위의 숫자를

MiB,GiB처럼 사람이 읽기 쉬운 단위로 바꿔준다.

- Byte 단위의 숫자를

sum(bytes_on_disk)- 각 테이블 그룹별로 모든 데이터 파트를 압축 후 실제 크기를 합산

sum(data_uncompressed_bytes)- 각 테이블 그룹별로 모든 데이터 파트의 압축 전 원본 크기를 합산

compression_ratio(원본 크기 / 압축 후 크기)를 계산하여 압축률을 보여준다.

- 결과

table compressed_size uncompressed_size compression_ratio patients 2.30 KiB 358.00 B 0.15 medical_records 2.04 KiB 808.00 B 0.39 1.0보다 낮은 비는 원본보다 압축 후가 오히려 커졌음을 의미한다.- 이는 현재 데이터가 너무 적아서 발생하는 정상적인 현상

- ClickHouse가 데이터를 저장할 때는 데이터 자체뿐만 아니라 메타데이터, 체크섬 등 추가 정보가 담긴 데이터 파트를 만들기 때문

파티션별 데이터 분포 확인

SELECT partition, count() as parts_count, formatReadableSize(sum(bytes_on_disk)) as size_on_disk FROM system.parts WHERE database = 'medical' AND table = 'medical_records' GROUP BY partition ORDER BY partition;- 특정 테이블(

medical_records)의 데이터가 어떤 파티션에 얼마나 분포되어 있는지 보여준다. - 동작 원리

FROM system.parts WHERE ... table = 'medical_records'medical_records테이블에 속한 데이터 파트만 필터링

GROUP BY partition- 상자들을 우리가

PARTITION BY toYYYYMM(...)로 지정했던 파티션 키(202401,202402등)를 기준으로 그룹을 짓습니다.

- 상자들을 우리가

count() as parts_count- 각 파티션 그룹이 몇 개의 데이터 파트로 이루어져 있는지 카운트

- 카운트가 크면 현재 백그라운드 병합 작업이 완료되지 않음을 의미

- 단, 데이터 삽입이 없는데도 오랫동안 줄어들지 않는다면 문제가 될 수 있다.

sum(bytes_on_disk) as size_on_disk- 각 파티션 그룹이 디스크에서 차지하는 총 크기

- 결과

partition parts_count size_on_disk 202402 1 2.04 KiB 1이라는 것은 가장 이상적인 상태- 해당 파티션에 대한 모든 병합 작업이 완료되어 데이터가 완벽하게 최적화되었다는 뜻

- 특정 테이블(

Docker 사용 시 주의사항

Docker 환경에서는 컨테이너 재시작 시 데이터가 사라질 수 있다. docker-compose.yml에서 volumes 설정으로 데이터를 보존해야 한다.

docker-compose down

docker-compose up -d

성능 최적화 팁

로컬 개발 환경에서도 ClickHouse의 성능을 체험해보려면 메모리 설정을 적절히 조정해야 한다. 일반적으로 사용 가능한 RAM의 50-70% 정도를 ClickHouse에 할당하는 것이 좋다.

<max_server_memory_usage>8000000000</max_server_memory_usage> <!-- 8GB -->

상세 설명

MergeTree 엔진이란?

- ClickHouse의 기본이자 핵심 스토리지 엔진

- 대용량 데이터를 컬럼 기반으로 저장하고 사용자가 지정한 정렬 키(

ORDER BY)에 따라 자동 정렬하는 엔진 - 분석형 워크로드(OLAP)에 최적화된 설계

- 실시간 INSERT와 빠른 SELECT를 동시에 지원

MergeTree가 특별한 이유

- 가장 중요하고 가장 많이 사용되는 엔진

- 압축 알고리즘과 벡터화 처리가 모두 MergeTree에서 구현된다.

- 지속적인 백그라운드 최적화를 통해 쿼리 성능을 자동으로 향상시킨다

데이터 저장과 병합 원리

INSERT 시점 백그라운드 병합 후 ┌──────────────┐ ┌─────────────────┐ │ Part 1 │ │ │ │ (새 데이터) │ => 병합 => │ 최적화된 │ ├──────────────┤ │ 단일 Part │ │ Part 2 │ │ │ │ (새 데이터) │ └─────────────────┘ └──────────────┘- INSERT마다 새로운 데이터 Part 생성 ⇒ 작은 파일들이 많아진다.

- 백그라운드에서 자동 병합 ⇒ 큰 파일로 합쳐져 성능 향상

- 압축과 정렬 최적화 ⇒ 쿼리 속도 대폭 개선

왜 "MergeTree"라는 이름인가?

- Merge - 작은 데이터 조각들을 큰 조각으로 병합

- Tree - 정렬된 데이터 자체가 거대한 색인(인덱스) 역할을 하여, B-Tree처럼 빠르게 원하는 데이터 범위를 찾아갈 수 있다

- MySQL의 B-Tree 인덱스와 유사하지만, 전체 데이터가 정렬된 상태로 저장된다

MergeTree (기본형)

CREATE TABLE medical_analytics ( record_date Date, hospital_id String, patient_count UInt32, revenue Decimal(12,2), avg_stay_days Float32 ) ENGINE = MergeTree() ORDER BY (record_date, hospital_id) PARTITION BY toYYYYMM(record_date);특징

- 가장 기본적이고 범용적인 엔진

- 중복 데이터를 그대로 유지 (중복 제거 X)

- 시간순 append-only 데이터에 최적화

- 한 번 기록되면 수정되지 않는 데이터

- 시간 순서대로 계속 쌓이는 데이터

INSERT는 빠르고,UPDATE/DELETE는 비효율적- 예시 : 로그성 데이터, 이벤트 데이터

적합한 의료 데이터

- 환자 진료 기록 (각 방문마다 새 레코드)

- 과거 진료 기록은 수정되지 않는다 (법적 요구사항)

- 의료기기 센서 데이터 (시계열 로그)

- 센서 값은 한 번 측정되면 변경 불가

- 초/분 단위로 대량 데이터가 시간순 누적

- 수술/검사 이력 (변경되지 않는 팩트 데이터)

- 이미 완료된 의료 행위는 기록 변경 불가

- 환자 진료 기록 (각 방문마다 새 레코드)

ReplacingMergeTree (중복 제거)

CREATE TABLE patients_master ( patient_id String, name String, birth_date Date, phone String, address String, updated_at DateTime DEFAULT now() -- 버전 컬럼 (이름 자유) ) ENGINE = ReplacingMergeTree(updated_at) -- 버전 컬럼 지정 ORDER BY patient_id PARTITION BY toYear(birth_date);동작 원리

같은 ORDER BY 키를 가진 행들 중 최신 버전만 유지

버전 컬럼(

updated_at) 값이 가장 큰 행이 최종 버전비교 가능한(Comparable) 타입이면 모두 사용 가능

이름은 자유롭게 설정 가능

ReplacingMergeTree()로 버전 컬럼이 없다면 전체 행 비교(즉, 완전히 동일한 행만 제거)

백그라운드 병합 시점에 중복 제거 수행 (즉시 X)

적합한 의료 데이터

- 환자 마스터 정보 (연락처, 주소 변경 시 최신 버전만 필요)

- 환자 정보는 변경되지만 현재 정보만 중요 (중복 제거 필요)

- 자동으로 최신 버전만 유지

- 의료진 정보 (부서 이동, 직급 변경 등)

- 의사의 현재 소속 부서/직급만 필요 (과거 이력 불필요 ⇒ 자동 제거)

- 병원 정보 (주소, 연락처, 진료과목 변경)

- 병원의 현재 운영 정보만 필요 (자동 정리)

- 환자 마스터 정보 (연락처, 주소 변경 시 최신 버전만 필요)

주의사항

병합이 이루어지기 전에는 중복 데이터 존재

이때는

FINAL키워드로 쿼리해야 중복 제거된 결과 확인 가능❌ FINAL 없이 조회

SELECT * FROM patients_master WHERE patient_id = 'P001'; ---------------------------------------------------------- /* 결과: 3개 행이 모두 나옴 P001 | 김철수 | 010-1111-1111 | 2024-01-01 10:00:00 P001 | 김철수 | 010-2222-2222 | 2024-02-15 14:30:00 P001 | 김철수 | 010-3333-3333 | 2024-03-10 09:15:00 */

- 실시간으로 중복 제거되지 않는다

- 병합 전

- 중복된 여러 행이 존재 (FINAL 없으면 모두 조회된다)

- 병합 중

- 백그라운드에서 중복 제거 작업 진행

- 병합 후

- 물리적으로 최신 행만 남는다 (FINAL 없어도 1개만 조회된다)

- 병합 전

SummingMergeTree (사전 집계)

CREATE TABLE daily_hospital_stats ( stat_date Date, hospital_id String, department String, patient_count UInt32, -- 자동 합계 total_revenue Decimal(12,2), -- 자동 합계 avg_rating Float32 -- 합계되지 않음 (평균은 수동 계산 필요) ) ENGINE = SummingMergeTree((patient_count, total_revenue)) -- 합계할 컬럼 지정 ORDER BY (stat_date, hospital_id, department) PARTITION BY toYYYYMM(stat_date);동작 원리

- SummingMergeTree( )에 지정된 컬럼들(

patient_count,total_revenue)만 합계된다.- 단, ORDER BY에 있는 컬럼은 지정하면 안된다

- 반드시 숫자 타입 컬럼만 지정해야 한다.

- 지정하지 않는다면 모든 숫자 컬럼 자동 합계 (권장 X)

- 같은 ORDER BY 키를 가진 행들의 숫자 컬럼을 자동 합계 ⭐

- 미리 집계된 결과를 저장하여 쿼리 속도 극대화

ORDER BY가 동일한 데이터는 백그라운드 작업 시 하나의 데이터로 계속 집계되어 저장된다.

단, 백그라운드 작업 전에는 여러 데이터가 있지만, 작업 후에는 ORDER BY가 같다면 1개만 남는다.

(개별 데이터 보존 X)

INSERT할 때마다 바뀌는 게 아니라, 백그라운드에서 병합 시 집계 결과를 저장한다

- SummingMergeTree( )에 지정된 컬럼들(

적합한 의료 데이터

- 일별/월별 병원 통계 (환자 수, 매출, 수술 건수)

- 자동으로 같은 날짜 + 병원 + 부서의 데이터를 합계

- 병원 전체 합계를 별도 쿼리로 조회

- 부서별 KPI 지표 (진료 건수, 수익, 만족도)

- 자동으로 시간대별 데이터를 일별로 집계

- 매번 GROUP BY 계산 불필요

- 의료기기 사용량 집계 (시간당 사용률, 총 사용 시간)

- 기기별 누적 사용량을 자동으로 집계

- 사용할 때마다 증가하는 카운터성 데이터

- 일별/월별 병원 통계 (환자 수, 매출, 수술 건수)

장점

- 집계 쿼리가 극도로 빠름 (이미 계산된 값)

- 저장 공간 절약

- 여러 개의 원본 행들이 1개의 집계 행으로 합쳐진다

제한사항

- 평균값은 직접 계산 불가 (합계 ÷ 개수로 직접 계산)

- ORDER BY 키가 같은 데이터만 집계

- 유연한 집계 불가능

MySQL과의 차이점

항목 MySQL ClickHouse Primary Key 유일성 보장 필수 유일성 보장 안함 ORDER BY 데이터 정렬만 스토리지 구조 결정 인덱스 역할 B-Tree 인덱스 별도 ORDER BY가 인덱스 역할 중복 처리 중복 입력 시 오류 중복 허용 (엔진별로 다름) ClickHouse ORDER BY의 핵심 역할

CREATE TABLE patient_visits ( visit_date Date, patient_id String, hospital_id String, doctor_id String, diagnosis_code String ) ENGINE = MergeTree() ORDER BY (patient_id, visit_date);- ORDER BY (patient_id, visit_date)

- 이것이 스토리지 구조를 결정한다.

- 물리적 데이터 정렬

- 디스크에 실제로 이 순서로 저장된다

- 쿼리 성능 최적화

- ORDER BY와 동일한 순서로 조회 시 극도로 빠르다.

- 이미 정렬된 스토리지 구조에 따라 연속된 블록을 읽기 때문이다.

- 데이터 블록 건너뛰기

- ORDER BY 컬럼 : 물리적 정렬로 자동으로 데이터 블록 건너뛰기

- 기타 컬럼 : 스킵 인덱스 선언으로 블록 건너뛰기

- ORDER BY (patient_id, visit_date)

ORDER BY 설계가 중요한 이유

✅ 매우 빠른 쿼리

SELECT * FROM patient_visits WHERE patient_id = 'P001' AND visit_date >= '2024-01-01' ORDER BY patient_id, visit_date;- WHERE 절이 테이블 ORDER BY 순서와 일치하는 경우

- 연속된 데이터 블록을 읽기 때문에 쿼리가 매우 빠르다.

- WHERE 절의 첫 번째 조건이 테이블 ORDER BY의 첫 번째 컬럼과 일치

- 1순위 컬럼만 또는 1, 2순위 컬럼 순서대로

- WHERE 절이 테이블 ORDER BY 순서와 일치하는 경우

❌ 느린 쿼리

SELECT * FROM patient_visits WHERE doctor_id = 'D001' -- ORDER BY에 doctor_id가 없음 ORDER BY diagnosis_code; -- ORDER BY와 완전히 다른 정렬- WHERE 절이 테이블 ORDER BY와 다른 패턴

- ORDER BY에 없는 컬럼으로 필터링

- ORDER BY 순서를 건너뛰는 필터링

- WHERE 절이 테이블 ORDER BY와 다른 패턴

최적 ORDER BY 설계

쿼리 패턴 분석과 ORDER BY 결정

주요 쿼리 패턴 최적 ORDER BY 이유 환자별 시계열 조회 (patient_id, visit_date)환자 → 날짜 순 접근 병원별 일일 분석 (hospital_id, visit_date)병원 → 날짜 순 접근 진단별 통계 분석 (icd10_primary, visit_date)질병 → 날짜 순 접근 의사별 진료 현황 (doctor_id, visit_date)의사 → 날짜 순 접근 설계 우선순위

- 쿼리 빈도가 최우선 (가장 자주 사용되는 패턴)

- 카디널리티는 보조 고려사항 (동일한 중요도일 때)

- 최대 3-4개 컬럼까지만 사용 (너무 많으면 효과 감소)

- 실제 데이터 분포 확인해보기

ORDER BY 설계 예시

✅ 좋은 예 : 카디널리티 순서 고려

ORDER BY (hospital_id, department_code, visit_date, patient_id) -- 낮음(10개) 중간(50개) 높음(365일) 매우높음(10만명)❌ 나쁜 예 : 카디널리티 순서 잘못

ORDER BY (patient_id, hospital_id, department_code, visit_date) -- 매우높음 낮음 중간 높음

ClickHouse의 근본적 차이점

- ClickHouse 같은 분석 DB는 같은 이벤트가 여러 번 적재될 수 있음을 전제하기 때문에 Primary Key가 없고 중복 허용이 기본이다.

- 다른 분석 DB 중 하나인 Snowflake는 유일성 제약이 있다.

- MySQL과 같은 RDBMS는 Primary Key로 유일성 강제하고 중복 시 오류가 나타나기 때문에 Primary Key 레벨에서 유일성이 보장된다

- ClickHouse 같은 분석 DB는 같은 이벤트가 여러 번 적재될 수 있음을 전제하기 때문에 Primary Key가 없고 중복 허용이 기본이다.

중복 데이터 문제와 해결책

문제 상황

INSERT INTO patients_master VALUES ('P001', '김철수', '1985-03-15', ...); INSERT INTO patients_master VALUES ('P001', '김철수', '1985-03-15', ...); -- 중복!- 같은 환자 정보가 여러 번 입력된다. (데이터 중복)

해결책 1 : ReplacingMergeTree + FINAL

SELECT * FROM patients_master FINAL WHERE patient_id = 'P001';- ReplacingMergeTree로 중복 데이터를 백그라운드 작업으로 제거

- 백그라운드 병합 작업 전이여도 FINAL 키워드로 최신 버전만 조회

해결책 2 : GROUP BY로 중복 제거

SELECT patient_id, argMax(name, updated_at) as latest_name, argMax(phone, updated_at) as latest_phone FROM patients_master WHERE patient_id = 'P001' GROUP BY patient_id;- ReplacingMergeTree가 아닌 다른 엔진에서 중복을 제거하는 방법

- GROUP BY + argMax( )로 수동으로 최신 버전 선택

GROUP BY: 같은patient_id끼리 그룹화argMax(값, 기준): 기준이 최대인 행의 값을 선택P001 | 김철수 | 010-1111-1111 | 2024-01-01 10:00:00 P001 | 김철수 | 010-2222-2222 | 2024-02-15 14:30:00 -- updated_at이 가장 큼 P001 | 김철수 | 010-3333-3333 | 2024-01-10 09:15:00argMax(name, updated_at)→ "김철수"argMax(phone, updated_at)→ "010-2222-2222"

데이터 무결성 패턴

애플리케이션 레벨 중복 방지

삽입 전 존재 여부 확인

SELECT count() FROM patients_master WHERE patient_id = 'P001';존재하지 않을 때만 INSERT

INSERT INTO patients_master SELECT 'P001', '김철수', '1985-03-15', now() WHERE NOT EXISTS ( SELECT 1 FROM patients_master WHERE patient_id = 'P001' );- 이 패턴은 데이터 삽입이 동시에 발생할 확률이 낮은 환경이나 배치 작업에 유용

- 동시성이 높은 환경에서는 유일성을 보장하지 못할 수 있다.

- 동시에 여러 곳에서 데이터가 삽입될 경우, 두 개의 삽입 작업이 모두 존재하지 않음으로 판단할 수 있다.

고유 식별자 생성 패턴

UUID 활용한 유일성 보장

INSERT INTO medical_records VALUES ( generateUUIDv4(), 'P001', now(), -- ... 기타 컬럼들 );generateUUIDv4()- 고유한record_id자동 생성

타임스탬프 기반 복합 키

INSERT INTO sensor_data VALUES ( concat(device_id, '_', toString(toUnixTimestamp(now()))), device_id, now(), sensor_value );- 복합 유일키

concat(device_id, '_', toString(toUnixTimestamp(now())))

- 복합 유일키

환자 마스터 테이블 (ReplacingMergeTree)

CREATE TABLE patients_master ( patient_id String, name String, birth_date Date, gender Enum8('M' = 1, 'F' = 2), phone String, email String, address String, emergency_contact String, blood_type Enum8('A' = 1, 'B' = 2, 'AB' = 3, 'O' = 4), allergies Array(String), chronic_diseases Array(String), updated_at DateTime DEFAULT now(), is_active UInt8 DEFAULT 1 ) ENGINE = ReplacingMergeTree(updated_at) ORDER BY patient_id PARTITION BY toYear(birth_date) COMMENT '환자 마스터 정보 - 최신 버전만 유지';- 설계 특징

ReplacingMergeTree(updated_at)- 환자 정보 수정 시 최신 버전만 유지

ORDER BY patient_id- 환자별 빠른 조회를 위한 물리적 정렬 저장

PARTITION BY toYear(birth_date)- 파티션 전략으로 연령대별 데이터 분리

Array(String)- ClickHouse 배열 타입으로 알레르기, 만성질환 등 다중 값을 효율적으로 저장

- 설계 특징

진료 기록 테이블 (MergeTree)

CREATE TABLE medical_records ( record_id String, patient_id String, visit_date DateTime, hospital_id String, department_code String, doctor_id String, icd10_primary String, -- 주 진단코드 (ICD-10) icd10_secondary Array(String), -- 부 진단코드들 cpt_codes Array(String), -- 처치/수술 코드들 (CPT) symptoms Array(String), treatment_plan Text, prescription_drugs Array(String), visit_type Enum8('OUTPATIENT' = 1, 'INPATIENT' = 2, 'EMERGENCY' = 3), total_cost Decimal(10,2), insurance_coverage Decimal(10,2), created_at DateTime DEFAULT now() ) ENGINE = MergeTree() ORDER BY (patient_id, visit_date, hospital_id) PARTITION BY toYYYYMM(visit_date) COMMENT '환자 진료 기록 - 이력 데이터';설계 특징

MergeTree()- 진료 기록은 수정되지 않는 이력 데이터로 중복 허용

ORDER BY (patient_id, visit_date, hospital_id)- 환자별 시계열 조회에 최적화된 물리적 정렬

- 가장 빈번한 쿼리 패턴에 맞춘 순서 설계

PARTITION BY toYYYYMM(visit_date)- 월별 파티션으로 날짜 범위 쿼리 최적화

Enum8타입- 방문 유형 (외래/입원/응급)을 메모리 효율적으로 저장

Array(String)- 다중 진단/처치 코드를 효율적으로 저장

ICD-10/CPT 코드 체계 반영

- ICD-10 : 국제 질병 분류 코드 (

K25.9 = 위궤양) - CPT : 의료 처치/수술 코드 (

99213 = 외래 진료)

- ICD-10 : 국제 질병 분류 코드 (

ORDER BY 설계 의도

- 1순위 :

patient_id- 환자별 조회가 가장 빈번하니까

- 2순위 :

visit_date- 환자의 시계열 분석

- 이미 시간 순으로 정렬하여 추가 정렬 작업 불필요

- 3순위 :

hospital_id - 이렇게 하면 물리적으로 우선 순위에 따라 연속 저장된다

- 1순위 :

일별 통계 테이블 (SummingMergeTree)

CREATE TABLE daily_department_stats ( stat_date Date, hospital_id String, department_code String, -- 자동 합계될 컬럼들 outpatient_count UInt32, inpatient_count UInt32, emergency_count UInt32, total_revenue Decimal(12,2), total_patients UInt32, -- 수동 계산이 필요한 컬럼들 avg_cost_outpatient Decimal(10,2), avg_stay_days Float32, updated_at DateTime DEFAULT now() ) ENGINE = SummingMergeTree(( outpatient_count, inpatient_count, emergency_count, total_revenue, total_patients )) ORDER BY (stat_date, hospital_id, department_code) PARTITION BY toYYYYMM(stat_date) COMMENT '부서별 일간 통계 - 자동 집계';설계 특징

SummingMergeTree((outpatient_count, inpatient_count, ...))- 숫자 컬럼 자동 합계로 백그라운드 통계 집계

- 지정된 컬럼만 합계하여 의도치 않은 집계 방지

ORDER BY (stat_date, hospital_id, department_code)- 날짜별 ⇒ 병원별 ⇒ 부서별 계층적 집계 구조

- 자주 쓰이는 쿼리 패턴과 카디널리티 순서(낮음 → 높음)을 고려한다

PARTITION BY toYYYYMM(stat_date)- 월별 파티션으로 통계 조회 성능 향상

- 수동 계산 컬럼 분리

- 평균값 컬럼은 SummingMergeTree 대상에서 제외

- 쿼리 시

sum(total_revenue) / sum(total_patients)로 정확한 평균 계산

자동 집계 장점

- 쿼리 성능 극대화

- 매번

GROUP BY sum()을 계산할 필요 없다 - 이미 합계된 결과를 바로 조회 ⇒ 초고속 응답

- 매번

- 저장 공간 효율성

- 여러 개의 일별 데이터가 1개의 집계 데이터로 압축

- 원본 개별 기록 대신 합계 결과만 보관

- 대시보드 응답 최적화

- 월간/연간 통계 조회 시 즉시 응답 가능

- 복잡한 집계 연산 없이 단순 조회만으로 분석

- 쿼리 성능 극대화

평균값 계산 방법

SELECT hospital_id, department_code, sum(total_revenue) as total_revenue, sum(total_patients) as total_patients, if(sum(total_patients) > 0, sum(total_revenue) / sum(total_patients), 0) as avg_revenue_per_patient FROM daily_department_stats WHERE stat_date >= '2024-01-01' GROUP BY hospital_id, department_code ORDER BY avg_revenue_per_patient DESC;- 1단계

- SummingMergeTree가 일별 데이터를 자동 합계

- 2단계

- 쿼리에서

sum()으로 월간/연간 재집계

- 쿼리에서

- 3단계

총수익 ÷ 총환자수로 정확한 수동 평균 계산

if()함수로 0으로 나누기 방지

- 1단계

설계된 테이블을 활용한 JOIN 쿼리

환자별 진료 이력 종합 조회

SELECT p.name as patient_name, h.hospital_name, d.name as doctor_name, mr.visit_date, mr.icd10_primary, mr.total_cost FROM medical_records mr JOIN patients p FINAL ON mr.patient_id = p.patient_id JOIN hospitals h FINAL ON mr.hospital_id = h.hospital_id JOIN doctors d FINAL ON mr.doctor_id = d.doctor_id WHERE mr.patient_id = 'P001' ORDER BY mr.visit_date DESC;- FINAL로 최신 환자 정보만 사용

병원별 월간 성과 분석

SELECT toYYYYMM(ds.stat_date) as month, ds.hospital_id, sum(ds.total_revenue) as monthly_revenue, sum(ds.patient_count) as monthly_patients, if(monthly_patients > 0, monthly_revenue / monthly_patients, 0) as avg_revenue_per_patient FROM daily_stats ds WHERE ds.stat_date >= '2024-01-01' GROUP BY month, ds.hospital_id ORDER BY month, monthly_revenue DESC;

MergeTree 최적화 요소

ORDER BY 설계

- 가장 빈번한 쿼리 패턴에 맞춰 설계

- 카디널리티 낮은 컬럼부터 배치

- 3-4개 컬럼 이내로 제한

파티셔닝 전략

- 날짜 기반 파티셔닝 (월별 권장)

- 파티션당 적정 크기 유지 (1GB-10GB)

- 너무 작으면 ⇒ 파티션 관리 오버헤드 증가

- 너무 크면 ⇒ 쿼리 시 불필요한 데이터까지 스캔

- 쿼리에서 파티션 키 활용하기

압축 최적화

- 자주 조회되는 컬럼 : LZ4 (빠른 해제)

- 보관용 데이터 : ZSTD (높은 압축률)

- 타입별 최적 압축 코덱 선택

메모리 사용량 최적화 예시

-- 대용량 테이블 설정 예시 CREATE TABLE large_medical_data ( -- ... 컬럼 정의 ) ENGINE = MergeTree() ORDER BY (patient_id, visit_date) SETTINGS index_granularity = 8192, -- 기본값, 메모리 사용량 조절 merge_max_block_size = 8192, -- 병합 시 블록 크기 max_compress_block_size = 1048576, -- 압축 블록 크기 min_compress_block_size = 65536, -- 최소 압축 블록 크기 max_part_loading_threads = 4; -- 파트 로딩 스레드 수- 테이블 생성 시

SETTINGS구문을 통해 세부 동작을 직접 제어하여 메모리 사용량을 튜닝할 수 있다index_granularity(인덱스 간격)merge_max_block_size(병합 시 메모리 사용량) 등

- 테이블 생성 시

MergeTree 엔진 선택 가이드

데이터 특성 권장 엔진 사용 예시 변경되지 않는 이벤트 MergeTree 진료기록, 센서로그, 거래내역 마스터 데이터 ReplacingMergeTree 환자정보, 의료진정보, 병원정보 집계가 필요한 데이터 SummingMergeTree 일별통계, 부서별KPI, 매출집계 증분 집계 데이터 AggregatingMergeTree 실시간 대시보드, 복잡한 지표 - 테이블 생성 시

SETTINGS구문을 통해index_granularity(인덱스 간격),merge_max_block_size(병합 시 메모리 사용량) 등 세부 동작을 직접 제어하여 메모리 사용량을 튜닝할 수 있다

- 테이블 생성 시

실무에서 자주 하는 실수들

ORDER BY를 MySQL Primary Key처럼 사용

- 문제 : ClickHouse는 유일성 보장 X

- 해결 : 중복 데이터 처리 전략 필요

너무 많은 컬럼을 ORDER BY에 포함

- 문제 : 너무 많은 컬럼을 ORDER BY에 포함

- 해결 : 3-4개 컬럼 이내 권장

파티션을 너무 세밀하게 분할

- 문제 : 일별 파티션은 보통 과도하다

- 해결 : 월별 파티션이 일반적으로 최적

ReplacingMergeTree에서 FINAL 누락

-- ✅ 올바른 사용 SELECT * FROM patients_master FINAL WHERE patient_id = 'P001'; -- ❌ 잘못된 사용 SELECT * FROM patients_master WHERE patient_id = 'P001'; -- 중복 가능- 문제

- 백그라운드 병합 전에

FINAL없이는 중복 데이터가 조회된다.

- 백그라운드 병합 전에

- 해결

- 항상 FINAL 사용 (안전하지만 성능 저하)

- 또는 병합 상태 확인 후 사용 (복잡하지만 최적화)

- 문제

MergeTree 설계 핵심 원칙

- 쿼리 패턴 먼저 분석 ⇒ ORDER BY 설계

- 데이터 특성 파악 ⇒ 엔진 타입 선택

- 생명주기 고려 ⇒ TTL 설정

- 성능 모니터링 ⇒ 지속적 최적화

TTL (Time To Live) 기본 개념

- 자동 데이터 삭제 기능으로 법적 보관 기간 준수

- 의료법 준수

- 의료기록 보관 의무 기간 후 자동 삭제

- 개인정보보호법 준수

- 목적 달성 후 자동 파기

- 비용 절약

- 오래된 데이터는 저렴한 스토리지로 이동

의료 데이터 TTL 설정 예시

CREATE TABLE patient_records ( patient_id String, visit_date Date, personal_info String, medical_data Text, created_at DateTime DEFAULT now() ) ENGINE = MergeTree() ORDER BY (patient_id, visit_date) TTL created_at + INTERVAL 10 YEAR DELETE, -- 10년 후 전체 행 삭제 created_at + INTERVAL 3 YEAR TO DISK 'cold', -- 3년 후 저비용 스토리지로 이동 created_at + INTERVAL 1 YEAR GROUP BY patient_id -- 1년 후 환자별 집계 데이터로 변환 SET personal_info = '', -- 개인정보 삭제 medical_data = 'ARCHIVED' -- 의료정보 아카이브 처리- 단계별 데이터 생명주기

- 0-1년

- 전체 데이터 유지 (핫 스토리지)

- 1-3년

개인정보 삭제, 의료정보만 유지

created_at + INTERVAL 1 YEAR GROUP BY patient_id SET personal_info = '', medical_data = 'ARCHIVED'- 1년 후 환자별로 그룹화하면서 개인정보 삭제

- 개인정보 ⇒ 빈 문자열

- 의료정보 ⇒ "ARCHIVED"로 변경

- 1년 후 환자별로 그룹화하면서 개인정보 삭제

- 3-10년

- 콜드 스토리지로 이동 (비용 절약)

- TO DISK - 스토리지 이동

created_at + INTERVAL 3 YEAR TO DISK 'cold’- 3년 후 저비용 스토리지로 이동

- 10년 후

- DELETE - 완전 삭제

created_at + INTERVAL 10 YEAR DELETE- 10년 후 전체 행 삭제

- 0-1년

- 단계별 데이터 생명주기

실무적 TTL 활용 패턴

로그 데이터 자동 삭제

CREATE TABLE audit_logs ( log_date Date, user_id String, action String, details Text ) ENGINE = MergeTree() ORDER BY log_date TTL log_date + INTERVAL 7 YEAR DELETE; -- 감사 로그 7년 보관- 7년 후엔 법적으로 불필요 ⇒ 완전 삭제

임시 데이터 빠른 삭제

CREATE TABLE temp_analysis ( analysis_date Date, temp_data Text ) ENGINE = MergeTree() ORDER BY analysis_date TTL analysis_date + INTERVAL 30 DAY DELETE; -- 30일 후 자동 삭제- 30일 후엔 분석 가치 없음 ⇒ 빠른 정리

개인정보 마스킹

CREATE TABLE patient_analytics ( record_date Date, patient_id String, name String, diagnosis_code String ) ENGINE = MergeTree() ORDER BY record_date TTL record_date + INTERVAL 5 YEAR GROUP BY patient_id SET name = 'MASKED'; -- 5년 후 이름 마스킹- 5년 전 :

김철수 | 당뇨 | 서울시 강남구 - 5년 후 :

MASKED | 당뇨 | MASKED

- 5년 전 :

스킵 인덱스가 필요한 상황

ORDER BY에 없는 컬럼으로 검색 ⇒ 전체 스캔 발생

SELECT * FROM medical_records WHERE doctor_id = 'D001'; --doctor_id가 ORDER BY에 없어서 모든 블록을 다 확인해야 한다

문자열 부분 검색 ⇒ 전체 스캔 발생

SELECT * FROM medical_records WHERE patient_name LIKE '%김%';- "김"이 들어간 이름을 찾으려면 모든 환자 이름을 다 봐야 한다

범위가 넓은 숫자 검색 ⇒ 많은 블록 읽기

SELECT * FROM medical_records WHERE total_cost BETWEEN 50000 AND 200000;- 5만원~20만원 사이 진료비를 찾으려면 모든 비용 데이터를 확인해야 한다.

스킵 인덱스 설정

CREATE TABLE medical_records_optimized ( patient_id String, visit_date Date, doctor_id String, diagnosis_name String, patient_name String, total_cost Decimal(10,2), -- 스킵 인덱스들 INDEX idx_doctor doctor_id TYPE set(100) GRANULARITY 3, INDEX idx_name patient_name TYPE ngrambf_v1(4, 256, 2, 0) GRANULARITY 1, INDEX idx_cost total_cost TYPE minmax GRANULARITY 2, INDEX idx_diagnosis diagnosis_name TYPE bloom_filter() GRANULARITY 1 ) ENGINE = MergeTree() ORDER BY (patient_id, visit_date);- 각 인덱스 타입별 활용

set(100)- 의사 ID처럼 카디널리티가 낮은 값들에 사용

- 종류가 적은 데이터용

ngrambf_v1- 환자 이름 부분 검색(

LIKE '%김%')에 사용 - 이름을 작은 조각으로 나눠서 저장 ("김철수" → "김철", "철수")

- 환자 이름 부분 검색(

minmax- 비용처럼 숫자 범위 검색

- 각 블록의 최솟값/최댓값 저장한다.

bloom_filter- 진단명처럼 정확한 매칭 검색에 사용

- "위궤양"이라는 진단명이 있는지 빠르게 확인할 수 있다.

- 있으면 블록 확인, 없으면 건너뛰기

- 각 인덱스 타입별 활용

스킵 인덱스 효과 측정

인덱스 적용 전후 성능 비교

SELECT query, -- 어떤 쿼리인지 read_rows, -- 몇 개 행을 읽었는지 read_bytes, -- 몇 바이트를 읽었는지 query_duration_ms -- 얼마나 오래 걸렸는지 FROM system.query_log WHERE query LIKE '%medical_records%' AND event_time >= now() - INTERVAL 1 HOUR ORDER BY query_duration_ms DESC;특정 쿼리의 실행 계획 확인

EXPLAIN indexes = 1 SELECT * FROM medical_records_optimized WHERE doctor_id = 'D001';- 스킵 인덱스를 사용했는지, 몇 개 블록을 건너뛰었는지 알 수 있다.

성능 개선 지표

read_rows- 읽은 행 수 (적을수록 좋음)

read_bytes- 읽은 바이트 수 (적을수록 좋음)

query_duration_ms- 쿼리 실행 시간 (짧을수록 좋음)

상세 설명

ARRAY JOIN의 핵심 원리

MySQL에서는 JSON 배열을 처리하려면 복잡한 함수들을 써야 한다.

ClickHouse는 배열을 테이블의 행으로 펼치는 ARRAY JOIN을 제공한다.

-- 의료 기록에서 증상 배열을 개별 행으로 펼치기 SELECT patient_id, visit_date, diagnosis_name, symptom_item FROM medical_records ARRAY JOIN symptoms AS symptom_item WHERE patient_id = 'P001';ARRAY JOIN은 1개 행에 있던 배열의 요소들을 별도의 행로 펼쳐주는 기능이다.

결과

patient_id visit_date diagnosis_name symptom_item P001 2024-02-01 09:00:00 위궤양 복통 P001 2024-02-01 09:00:00 위궤양 소화불량

ARRAY JOIN 없이 조회 시

SELECT patient_id, visit_date, diagnosis_name, symptoms FROM medical_records WHERE patient_id = 'P001';결과

patient_id visit_date diagnosis_name symptoms P001 2024-02-01 09:00:00 위궤양 [’복통’, ’소화불량’]

하나의 테이블에 여러 배열이 있는 경우

CREATE TABLE medical_records_advanced ( record_id String, patient_id String, visit_date DateTime, symptoms Array(String), -- 증상 배열 icd10_codes Array(String), -- 진단코드 배열 prescription_drugs Array(String), -- 처방약 배열 lab_tests Array(String) -- 검사항목 배열 ) ENGINE = MergeTree() ORDER BY (patient_id, visit_date);여러 배열을 동시에 처리하는 패턴

-- 증상별 처방약 매핑 분석 SELECT symptom, groupArray(DISTINCT drug) AS related_drugs, count() AS frequency FROM medical_records_advanced ARRAY JOIN symptoms AS symptom, prescription_drugs AS drug GROUP BY symptom ORDER BY frequency DESC;원본 결과

patient_id symptoms prescription_drugs P001 ['복통', '소화불량'] ['제산제', '소화제'] P002 ['복통', '두통'] ['진통제', '위장약'] P003 ['소화불량'] ['소화제'] ARRAY JOIN 결과

patient_id symptom drug P001 복통 제산제 P001 소화불량 소화제 P002 복통 진통제 P002 두통 위장약 P003 소화불량 소화제 - 각 배열의 같은 인덱스에 있는 요소끼리 순서대로 묶여 새로운 행을 만든다.

- 즉, 각 배열의 첫 번째끼리 매칭, 이후 두 번째끼리 매칭된다.

groupArray( ) 결과

symptom related_drugs frequency 복통 ['제산제', '진통제'] 2 소화불량 ['소화제'] 2 두통 ['위장약'] 1 groupArray(지정컬럼)- ARRAY JOIN으로 펼친 행들을 다시 지정컬럼 기준 그룹별로 묶어 배열화하는 것A

DISTINCT drug: 모을 때 중복 제거groupArray(drug): 같은 그룹 안의 모든 약 다시 배열로 모은다.- 복통에는 ‘제산제’, ‘진통제’가 처방되었다.

주의사항

symptoms = ['복통', '소화불량', '속쓰림'] (3개) prescription_drugs = ['제산제', '소화제'] (2개) -- 결과: ('복통', '제산제'), ('소화불량', '소화제') 만 생성됨- 여러 배열을 ARRAY JOIN하면 각 배열의 첫 번째 요소끼리 묶이고, 다음으로 두 번째 요소끼리 묶여 순서대로 쌍으로 묶인다

- 만약 배열 길이가 다르면, 가장 짧은 배열 길이를 기준으로 처리되므로 주의해야 한다.

LEFT ARRAY JOIN으로 빈 배열 처리

-- 처방약이 없는 환자도 포함하여 조회 SELECT patient_id, diagnosis_name, coalesce(drug, 'No Prescription') AS prescription_status FROM medical_records_advanced LEFT ARRAY JOIN prescription_drugs AS drug WHERE visit_date >= '2024-02-01';- LEFT ARRAY JOIN으로 빈 배열 포함시키고,

coalescs()함수로 null 값 처리를 한다.

- LEFT ARRAY JOIN으로 빈 배열 포함시키고,

기존 JOIN 방식의 한계

-- ICD-10 코드 마스터 테이블 생성 CREATE TABLE icd10_master ( code String, korean_name String, english_name String, category String ) ENGINE = MergeTree() ORDER BY code; -- 샘플 데이터 INSERT INTO icd10_master VALUES ('K25.9', '위궤양, 상세불명', 'Gastric ulcer, unspecified', '소화기계'), ('K30', '기능성 소화불량', 'Functional dyspepsia', '소화기계'), ('J44.1', '급성 악화를 동반한 만성폐쇄성폐질환', 'COPD with acute exacerbation', '호흡기계'), ('J06.9', '급성 상기도감염, 상세불명', 'Acute upper respiratory infection', '호흡기계'), ('E11.9', '인슐린-비의존 당뇨병', 'Type 2 diabetes mellitus', '내분비계');진료 기록 테이블 (매일 수천~수만 건 발생)

record_id patient_id icd10_code visit_date cost R001 P001 K25.9 2024-01-01 50000 R002 P002 K30 2024-01-01 30000 R003 P003 J44.1 2024-01-01 80000 R004 P004 K25.9 2024-01-01 45000 … … ... … … ICD-10 코드 마스터 테이블 (거의 변경되지 않음)

code korean_name english_name category K25.9 위궤양, 상세불명 Gastric ulcer 소화기계 K30 기능성 소화불량 Functional dyspepsia 소화기계 J44.1 만성폐쇄성폐질환 COPD 호흡기계 E11.9 인슐린-비의존 당뇨병 Type 2 diabetes 내분비계

-- 진료비 통계 SELECT mr.patient_id, icd.korean_name AS diagnosis_korean, -- 한국어 병명이 필요 mr.cost, mr.visit_date FROM medical_records mr JOIN icd10_master icd ON mr.icd10_code = icd.code WHERE mr.visit_date >= '2024-01-01';- 진료비 통계를 조회할 때마다, 이런 쿼리를 날린다.

- JOIN 연산은 실행할 때마다 매번 디스크 I/O와 테이블 스캔이 발생하여, 수백만 건의 데이터에 대한 연산 비용이 발생

- 성능 비교

- JOIN 방식

- 디스크 읽기 → 테이블 스캔 → 매칭 → 결과 (수십ms)

- 딕셔너리 방식

- 메모리에서 키로 바로 조회 (수μs)

- JOIN 방식

딕셔너리(Dictionary)란

딕셔너리는 키-값 쌍으로 데이터를 저장하는 자료구조

ClickHouse 딕셔너리는 자주 참조하는 데이터를 메모리에 미리 로드해두고, 키로 값을 빠르게 조회할 수 있게 해주는 시스템

딕셔너리가 필요한 이유

- 딕셔너리의 핵심은 자주 참조하는 작은 테이블을 메모리에 올려두고, 키로 바로 찾는 것이다.

- 일반적인 JOIN은 매번 디스크를 읽어야 하지만, 딕셔너리는 메모리에 캐시되어 극도로 빠르다

딕셔너리 동작 방식

딕셔너리 로드 (서버 시작 시 1회)

- ClickHouse 메모리에 로드

딕셔너리["K25.9"] = { korean_name: "위궤양, 상세불명", english_name: "Gastric ulcer", category: "소화기계" } 딕셔너리["K30"] = { korean_name: "기능성 소화불량", english_name: "Functional dyspepsia", category: "소화기계" }

- ClickHouse 메모리에 로드

빠른 조회 (매 쿼리마다)

- JOIN 없이 메모리에서 키로 바로 조회

외부 딕셔너리 설정 파일

<?xml version="1.0"?> <dictionaries> <dictionary> <!-- 1. 딕셔너리 식별 정보 --> <name>icd10_dict</name> <!-- 딕셔너리 이름 (쿼리에서 사용) --> <!-- 2. 데이터 소스 설정 --> <source> <clickhouse> <host>localhost</host> <!-- ClickHouse 서버 주소 --> <port>9000</port> <!-- 포트 번호 --> <user>admin</user> <!-- 데이터베이스 유저명 --> <password>1234</password> <!-- 비밀번호 --> <db>medical</db> <!-- 데이터베이스명 --> <table>icd10_master</table> <!-- 소스 테이블명 --> </clickhouse> </source> <!-- 3. 메모리 저장 방식 --> <layout> <hashed /> <!-- 해시 테이블 방식 (O(1) 조회 속도) --> </layout> <!-- 4. 딕셔너리 구조 정의 --> <structure> <!-- 키(Key) 정의 --> <id> <name>code</name> <!-- icd10_master.code 컬럼을 키로 사용 --> </id> <!-- 값(Value) 정의 - 여러 개 가능 --> <attribute> <name>korean_name</name> <!-- 속성명 --> <type>String</type> <!-- 데이터 타입 --> </attribute> <attribute> <name>english_name</name> <type>String</type> </attribute> <attribute> <name>category</name> <type>String</type> </attribute> </structure> <!-- 5. 갱신 주기 --> <lifetime>300</lifetime> <!-- 300초(5분)마다 소스 테이블에서 다시 로드 --> </dictionary> </dictionaries>config/icd10_dictionary.xml파일 생성

외부 딕셔너리 설정 요소

<name>- 딕셔너리 식별자- 쿼리에서

dictGet()이 참조할 이름 - 여러 딕셔너리가 있을 때 구분하는 식별자

- 쿼리에서

<source>- 데이터 소스ClickHouse 테이블뿐만 아니라 MySQL, PostgreSQL, HTTP, CSV 등도 가능

외부 데이터베이스에서 데이터를 가져올 수도 있다

- MySQL에서 데이터 가져오기

<source> <mysql> <host>mysql-server.hospital.com</host> <!-- MySQL 서버 주소 --> <port>3306</port> <!-- MySQL 포트 --> <user>clickhouse_user</user> <!-- MySQL 유저명 --> <password>secure_password</password> <!-- MySQL 비밀번호 --> <db>hospital_db</db> <!-- MySQL 데이터베이스명 --> <table>icd10_codes</table> <!-- MySQL 테이블명 --> <!-- 선택사항: 커스텀 쿼리 --> <query> SELECT code, korean_name, english_name, category FROM icd10_codes WHERE is_active = 1 </query> </mysql> </source> - HTTP API에서 가져오기

<source> <http> <url>https://api.who.int/icd10/codes</url> <format>JSON</format> <headers> <header> <name>Authorization</name> <value>Bearer your-api-token</value> </header> </headers> </http> </source>

<layout>- 메모리 저장 방식<flat />: 배열 방식 (키가 연속 숫자일 때)<cache />: LRU 캐시 방식 (메모리 절약)<range_hashed />: 범위 검색용<hashed />: 해시 테이블: 빠른 조회, 많은 메모리

<structure>- 딕셔너리 구조- 키(id), 값(attribute) 설정

- attribute는 name(속성명)과 type(데이터 타입) 설정 필요

<lifetime>- 갱신 주기- 소스 테이블이 변경되면 딕셔너리도 자동 갱신

0으로 설정하면 서버 재시작할 때만 갱신

dictGet( ) 함수

dicGet( ) 사용 방법

dictGet('딕셔너리명', '속성명', 키값)SELECT patient_id, icd10_code, dictGet('icd10_dict', 'korean_name', icd10_code) AS korean_name FROM medical_records;동작 과정

medical_records에서icd10_code값("K25.9")을 읽는다- 메모리의 icd10_dict에서 키 "K25.9" 검색

- 해당 키의

korean_name속성 반환 ("위궤양, 상세불명")

여러 속성 조회

SELECT patient_id, dictGet('icd10_dict', 'korean_name', icd10_code) AS korean_name, dictGet('icd10_dict', 'category', icd10_code) AS category, dictGet('icd10_dict', 'english_name', icd10_code) AS english_name FROM medical_records;배열 내 모든 값 조회

SELECT patient_id, icd10_codes, -- ['K25.9', 'K30', 'J44.1'] arrayMap(x -> dictGet('icd10_dict', 'korean_name', x), icd10_codes) AS korean_names FROM medical_records_advanced;['K25.9', 'K30', 'J44.1']배열의 각 요소에 대해dictGet('icd10_dict', 'korean_name', x)실행- 결과를 새 배열로 조합 -

['위궤양, 상세불명', '기능성 소화불량', '만성폐쇄성폐질환']

dictGet( ) 함수 장점

- 속도

- 메모리에서 O(1) 조회

- 간편성

- JOIN 문법 없이 간단 조회

- 배열 지원

- arrayMap과 조합 가능

- NULL 처리

- 키가 없으면 기본값 반환

- 속도

WITH TOTALS로 집계와 소계 한 번에 처리

WITH TOTALS란

- 소계는 마지막에 전체 합계도 같이 보고 싶을 때 사용한다

MySQL에서는 소계를 구하려면 ROLLUP이나 별도 쿼리가 필요하다.

그러나, ClickHouse는

WITH TOTALS로 한 번에 처리한다기본 문법

SELECT 컬럼들... FROM 테이블 GROUP BY 컬럼 WITH TOTALS [ORDER BY ...]- GROUP BY와 함께 사용 - GROUP BY 없으면 의미 없다

- 집계 함수와 함께 사용 -

COUNT(),SUM(),AVG()등

동작 원리

- 일반적인 GROUP BY 실행

- 모든 그룹의 집계 함수 결과를 다시 집계

- "Totals" 행에 전체 합계 추가

사용 예시

-- 부서별 환자 수와 전체 소계 SELECT department, count() AS patient_count, sum(cost) AS total_revenue FROM medical_records GROUP BY department WITH TOTALS ORDER BY total_revenue DESC;- 결과 Totals :

department patient_count total_revenue 응급의학과 1 180000.00 정형외과 1 120000.00 산부인과 1 85000.00 내과 2 70000.00 department patient_count total_revenue - 5 455000.00 - 한 번의 쿼리로 그룹별 통계 + 전체 합계를 동시에 얻는다

- 결과

LIMIT BY로 그룹별 상위 N개 조회

LIMIT BY란

- 그룹별 상위 N개가 필요한 경우 사용한다

MySQL에서는 그룹별 상위 N개를 구하려면 복잡한 윈도우 함수가 필요하다.

그러나, ClickHouse는

LIMIT BY로 한 번에 처리한다기본 문법

SELECT 컬럼들... FROM 테이블 [WHERE 조건] ORDER BY 정렬기준 LIMIT N BY 그룹컬럼- ORDER BY 필수 - 정렬 없으면 어떤 N개를 가져올지 모른다

- LIMIT N BY 그룹 기준

- 그룹 기준은 어떤 컬럼으로 그룹을 나눌지

- N은 각 그룹에서 몇 개씩 가져올지

동작 원리

- ORDER BY로 정렬

- 그룹 컬럼별로 데이터 묶기

- 각 그룹에서 상위 N개씩만 선택

사용 예시

-- 각 환자별 최근 진료 기록 2개씩만 조회 SELECT patient_id, visit_date, diagnosis_name, cost FROM medical_records ORDER BY patient_id, visit_date DESC LIMIT 2 BY patient_id;- 결과

patient_id visit_date diagnosis cost P001 2024-02-01 위염 40000 P001 2024-01-15 두통 25000 P002 2024-02-10 완치 30000 P002 2024-01-20 재진 50000 - 각 그룹(

patient_id)별로 N개씩만 가져온다

- 각 그룹(

- 결과

FINAL 키워드와 중복 제거 완벽 이해

ReplacingMergeTree에서 FINAL의 필요성

앞서 학습한 ReplacingMergeTree는 백그라운드에서 중복을 제거하므로, 실시간으로는 중복된 데이터가 보일 수 있다

FINAL은 지금 당장 중복 제거해서 최신 데이터만 보는 명령어이다

- 데이터의 최종적인 정확성이 필요할 때 사용하는 핵심 키워드

기본 문법

SELECT 컬럼들... FROM 테이블명 FINAL [WHERE 조건]- 테이블명 바로 뒤 -

FROM table_name FINAL - ReplacingMergeTree에서만 의미 있음 - 다른 엔진에서는 효과 없음

- 성능 비용 - 실시간 중복 제거라서 느릴 수 있음

- 테이블명 바로 뒤 -

동작 원리

- 테이블에서 데이터 읽기

- 중복된 키 찾기

- 최신 버전만 남기고 나머지 제거

- 결과 반환

중복 입력 테스트

-- 환자 마스터 데이터 중복 입력 시뮬레이션 INSERT INTO patients_master VALUES ('P001', '김철수', '1985-03-15', 'M', '010-1111-1111', now()); INSERT INTO patients_master VALUES ('P001', '김철수(수정)', '1985-03-15', 'M', '010-2222-2222', now());FINAL 없이 조회 (중복 표시됨)

SELECT * FROM patients_master WHERE patient_id = 'P001';patient_id name phone updated_at P001 김철수 010-1111-1111 2024-01-01 10:00:00 P001 김철수(수정) 010-2222-2222 2024-01-01 11:00:00 - 아직 병합 전이라면, 수정 전 데이터까지 조회된다.

FINAL로 조회 (최신 버전만 표시)

SELECT * FROM patients_master FINAL WHERE patient_id = 'P001';patient_id name phone updated_at P001 김철수(수정) 010-2222-2222 2024-01-01 11:00:00

성능을 고려한 중복 제거 패턴

-- 방법 1: FINAL SELECT * FROM patients_master FINAL WHERE patient_id = 'P001'; -- 방법 2: GROUP BY SELECT patient_id, argMax(name, updated_at) AS latest_name, argMax(phone, updated_at) AS latest_phone, argMax(address, updated_at) AS latest_address, max(updated_at) AS last_updated FROM patients_master WHERE patient_id = 'P001' GROUP BY patient_id;FINAL은 편리하지만 테이블 전체를 스캔해서 중복을 제거하기에 메모리 사용량이 많아 성능 비용이 발생한다.- 그렇기 때문에 대용량 데이터나 성능이 중요한 경우

GROUP BY + argMax()를 사용하는 것이 더 좋을 수 있다

특화 구문 조합 활용

WITH TOTALS + LIMIT BY 조합

SELECT department, patient_id, cost, visit_date FROM medical_records ORDER BY department, cost DESC LIMIT 2 BY department WITH TOTALS;- 부서별 TOP 환자 + 전체 통계 조회

- 상위 선택 + 통계를 한 번에

ORDER BY department, cost DESC로 부서별로 묶고, 각 부서 내에서 비용 높은 순으로 정렬LIMIT 2 BY department로 각 부서별로 상위 2명씩만 선택WITH TOTALS로 선택된 데이터들의 전체 합계도 같이 표시

FINAL + LIMIT BY 조합

SELECT patient_id, name, phone, updated_at FROM patients_master FINAL ORDER BY patient_id, updated_at DESC LIMIT 1 BY patient_id;- 각 환자별 최신 정보만 조회

- 중복 제거 + 그룹별 선택을 한 번에

FINAL로 중복 제거해서 최신 데이터만 가져옴ORDER BY patient_id, updated_at DESC로 환자별로 묶고, 최신 순으로 정렬LIMIT 1 BY patient_id로 각 환자별로 최신 1개씩만 선택

핵심 배열 처리 함수

arraySort( )

arraySort(배열) -- 배열 요소를 정렬arraySlice( )

arraySlice(배열, 시작위치, 개수) -- 배열 일부만 처리- 배열이 너무 클 때 일부만 처리해서 메모리 절약

has( ) vs hasAny( )

has(배열, 값) -- 특정 값이 있는지 확인 hasAny(배열1, 배열2) -- 배열1에 배열2의 요소 중 하나라도 있는지- true / false 반환

arrayFilter( ) vs arrayMap( )

arrayFilter(x -> 조건, 배열) -- 조건에 맞는 요소만 필터링 arrayMap(x -> 변환식, 배열) -- 각 요소를 변환['복통', '감기', '호흡곤란']에서 심각한 증상만 →['호흡곤란']['타이레놀', '부루펜']→['타이레놀 200mg', '부루펜 200mg']

배열 처리 함수 예시

arraySort( ) 예시

SELECT arraySort(symptoms) AS symptom_combination, count() AS frequency, groupArray(DISTINCT patient_id) AS affected_patients FROM medical_records_advanced WHERE length(symptoms) >= 2 -- 2개 이상 증상이 있는 경우만 GROUP BY symptom_combination HAVING frequency >= 2 ORDER BY frequency DESC;증상 동시 발생 패턴 분석으로 어떤 증상들이 자주 같이 나타나는지 분석하는 쿼리

원본 데이터

patient_id symptoms P001 ['복통', '소화불량'] P002 ['복통', '두통'] P003 ['소화불량', '복통'] P004 ['감기'] P005 ['복통', '두통'] 동작 과정

- WHERE 필터링 - 2개 이상 증상이 있는 경우만 필터링

patient_id symptoms P001 ['복통', '소화불량'] P002 ['복통', '두통'] P003 ['소화불량', '복통'] P005 ['복통', '두통'] - P004 제외

arraySort()로 증상 배열 정렬patient_id symptoms P001 ['복통', '소화불량'] P002 ['두통', '복통'] P003 ['복통', '소화불량'] P005 ['두통', '복통'] - GROUP BY - 증상 배열 기준으로 그룹화

- 그룹 1

['복통', '소화불량']→ P001, P003

- 그룹 2

['두통', '복통']→ P002, P004

- 그룹 1

- 집계 함수 -

count() - 집계 함수 -

groupArray()- 각 그룹 안에 있는 환자 ID들을 배열로 모으기 위해 사용

['복통', '소화불량']그룹- P001, P003 ⇒

['P001', 'P003']

- P001, P003 ⇒

['두통', '복통']그룹- P002, P004 ⇒

['P002', 'P004']

- P002, P004 ⇒

- 각 그룹 안에 있는 환자 ID들을 배열로 모으기 위해 사용

- HAVING

symptom_combination frequency affected_patients ['복통', '소화불량'] 2 ['P001', 'P003'] ['두통', '복통'] 2 ['P002', 'P005']

- WHERE 필터링 - 2개 이상 증상이 있는 경우만 필터링

has( ), hasAny( ) 예시

SELECT patient_id, visit_date, prescription_drugs, CASE WHEN has(prescription_drugs, '와파린') AND hasAny(prescription_drugs, ['아스피린', '이부프로펜']) THEN '출혈 위험 - 상호작용 주의' ELSE '안전' END AS interaction_warning FROM medical_records_advanced WHERE length(prescription_drugs) >= 2;처방약 상호작용 위험 검사로 와파린과 함께 먹으면 위험한 약이 처방되었는지 확인하는 쿼리

원본 데이터

patient_id visit_date prescription_drugs P001 2024-01-01 ['타이레놀', '소화제'] P002 2024-01-02 ['와파린', '아스피린', '비타민'] P003 2024-01-03 ['와파린', '소화제'] P004 2024-01-04 ['이부프로펜'] P005 2024-01-05 ['와파린', '이부프로펜', '감기약'] P006 2024-01-06 ['타이레놀', '비타민'] 동작 과정

- WHERE 필터링 - 처방약이 2개 이상인 환자만 필터링

patient_id visit_date prescription_drugs P001 2024-01-01 ['타이레놀', '소화제'] P002 2024-01-02 ['와파린', '아스피린', '비타민'] P003 2024-01-03 ['와파린', '소화제'] P005 2024-01-05 ['와파린', '이부프로펜', '감기약'] P006 2024-01-06 ['타이레놀', '비타민'] - P004 제외

- CASE WHEN -

has(),hasAny()로 배열 검사- 와파린이 있는데 이부프로펜 or 아스피린까지 함께 있는지 체크

patient_id prescription_drugs 경고 메시지 P001 ['타이레놀', '소화제'] 안전 P002 ['와파린', '아스피린', '비타민'] 출혈 위험 - 상호작용 주의 P003 ['와파린', '소화제'] 안전 P005 ['와파린', '이부프로펜', '감기약'] 출혈 위험 - 상호작용 주의 P006 ['타이레놀', '비타민'] 안전

- WHERE 필터링 - 처방약이 2개 이상인 환자만 필터링

arrayFilter( ) 예시

SELECT patient_id, symptoms, arrayFilter(x -> x IN ('호흡곤란', '가슴통증', '의식저하', '고열'), symptoms) AS serious_symptoms FROM medical_records_advanced WHERE length(arrayFilter(x -> x IN ('호흡곤란', '가슴통증', '의식저하', '고열'), symptoms)) > 0;심각한 증상만 필터링으로 응급상황이 필요한 환자를 식별 하는 쿼리

원본 데이터

patient_id symptoms P001 ['복통', '소화불량', '어지러움'] P002 ['호흡곤란', '가슴통증', '두통'] P003 ['감기', '기침', '콧물'] P004 ['의식저하', '고열', '복통'] P005 ['두통', '목아픔'] P006 ['호흡곤란', '어지러움'] 동작 과정

arrayFilter()로 각 환자별로 심각한 증상만 추출- '호흡곤란', '가슴통증', '의식저하', '고열'

patient_id symptoms arrayFilter 결과 P001 ['복통', '소화불량', '어지러움'] [ ] P002 ['호흡곤란', '가슴통증', '두통'] ['호흡곤란', '가슴통증'] P003 ['감기', '기침', '콧물'] [ ] P004 ['의식저하', '고열', '복통'] ['의식저하', '고열'] P005 ['두통', '목아픔'] [ ] P006 ['호흡곤란', '어지러움'] ['호흡곤란'] - WHERE 필터링 - 심각한 증상이 1개 이상인 환자만

patient_id symptoms serious_symptoms P002 ['호흡곤란', '가슴통증', '두통'] ['호흡곤란', '가슴통증'] P004 ['의식저하', '고열', '복통'] ['의식저하', '고열'] P006 ['호흡곤란', '어지러움'] ['호흡곤란'] - P001, P003, P005 제외

arrayMap( ) 예시

SELECT patient_id, prescription_drugs, arrayMap(x -> concat(x, ' 200mg'), prescription_drugs) AS drugs_with_dosage FROM medical_records_advanced;약물 투여량 계산으로 모든 처방약에 표준 용량(200mg)을 자동 추가 하는 쿼리

원본 데이터

patient_id prescription_drugs P001 ['타이레놀', '소화제'] P002 ['와파린', '아스피린', '비타민'] P003 ['이부프로펜', '감기약'] P004 ['항생제'] P005 ['타이레놀', '소화제', '진통제'] 동작 과정

arrayMap()으로 각 약물명에 '200mg' 문자열 추가patient_id prescription_drugs drugs_with_dosage P001 ['타이레놀', '소화제'] ['타이레놀 200mg', '소화제 200mg'] P002 ['와파린', '아스피린', '비타민'] ['와파린 200mg', '아스피린 200mg', '비타민 200mg'] P003 ['이부프로펜', '감기약'] ['이부프로펜 200mg', '감기약 200mg'] P004 ['항생제'] ['항생제 200mg'] P005 ['타이레놀', '소화제', '진통제'] ['타이레놀 200mg', '소화제 200mg', '진통제 200mg']

기타 유용한 배열 처리 함수들

- arrayExists( )

arrayExists(x -> 조건, 배열) -- 조건 만족 요소 존재 여부 (true/false 반환)- 배열에 조건을 만족하는 요소가 하나라도 있는지 확인

arrayExists(x -> x = '복통', ['복통', '두통'])→true- 예시 : "위험한 증상이 하나라도 있나?" 체크할 때

- indexOf( )

indexOf(배열, 값) -- 요소의 위치 찾기 (1부터 시작, 없으면 0)- 배열에서 특정 값의 첫 번째 위치를 반환

indexOf(['복통', '두통', '복통'], '두통')→2- 예시 : "특정 약물이 처방 순서상 몇 번째인가?" 확인할 때

- arrayCount( )

arrayCount(x -> 조건, 배열) -- 조건 만족 요소 개수- 배열에서 조건을 만족하는 요소의 개수를 세기

arrayCount(x -> length(x) > 2, ['복통', '두통', '소화불량'])→2(복통, 소화불량)- 예시 : "심각한 증상이 몇 개나 되나?" 셀 때

- arrayDistinct( )

arrayDistinct(배열) -- 중복 제거된 배열 반환- 배열에서 중복을 제거하고 고유한 요소들만 반환

arrayDistinct(['복통', '두통', '복통'])→['복통', '두통']- 예시 : "중복된 진단코드 제거" 할 때

- arrayUniq( )

arrayUniq(배열) -- 고유 요소 개수- 배열에서 중복을 제거한 후의 개수를 반환

arrayUniq(['복통', '두통', '복통'])→2- 예시 : "환자가 앓은 고유 질병 수" 셀 때

- arrayReduce( )

arrayReduce(집계함수, 배열) -- 배열에 집계함수 적용- 배열의 모든 요소에 집계 함수를 적용

arrayReduce('sum', [10, 20, 30])→60arrayReduce('avg', [10, 20, 30])→20- 예시 : "배열 내 수치들의 합계/평균" 구할 때

- arrayExists( )

실무 팁과 성능 최적화

효율적인 쿼리 작성 패턴

❌ 비효율적 : 큰 배열을 매번 JOIN

SELECT count() FROM medical_records mr ARRAY JOIN symptoms AS symptom WHERE symptom = '복통';- 문제점

- 메모리 사용량 증가 - 모든 증상을 개별 행으로 펼친다

- 불필요한 데이터 생성 - "복통" 하나 찾으려고 전체 배열 펼치기

- 문제점

✅ 효율적 : has( ) 함수 사용

SELECT count() FROM medical_records WHERE has(symptoms, '복통');- 장점

- 메모리 절약 - 배열을 펼치지 않고 바로 검색

- 빠른 처리 - O(n) 배열 스캔으로 즉시 판정

- 간단한 로직 - 복잡한 JOIN 없이 한 번에 처리

- ARRAY JOIN 방식 대비 5-10배 빠르다

- 장점

❌ 비효율적 : 딕셔너리 없는 반복 JOIN

SELECT mr.*, icd.korean_name FROM medical_records mr JOIN icd10_master icd ON mr.icd10_primary = icd.code;- 문제점

- 디스크 I/O 반복 - 매번 테이블을 디스크에서 읽는다

- JOIN 연산 비용 - 해시 테이블 생성 + 매칭 과정 반복

- 캐시 비효율 - 같은 코드를 수백 번 조회해도 매번 JOIN

- 문제점

✅ 효율적 : 딕셔너리 활용

SELECT *, dictGet('icd10_dict', 'korean_name', icd10_primary) AS korean_name FROM medical_records;- 장점

- 메모리 캐시 - 딕셔너리가 메모리에 존재

- O(1) 조회 - 해시 테이블로 즉시 검색

- 중복 제거 - 같은 코드 재조회 시 캐시에서 바로 반환

- JOIN 방식 대비 10-50배 빠르다

- 장점

메모리 사용량 최적화

대용량 배열 처리 시 메모리 절약

SELECT patient_id, arraySlice(symptoms, 1, 3) AS top_symptoms -- 상위 3개만 처리 FROM medical_records_advanced WHERE length(symptoms) > 10;- 환자별로 증상이 많을 때 (10개 이상)

arraySlice()함수 활용- 배열의 일부분만 추출하여 메모리 절약

- 활용 시나리오

- 환자별 주요 증상 TOP 3만 분석

- 처방약 중 핵심 약물만 체크

- 검사 결과 중 이상치만 확인

스트리밍 방식으로 큰 결과셋 처리

SELECT * FROM medical_records ORDER BY visit_date LIMIT 1000000 SETTINGS max_memory_usage = 1000000000; -- 1GB 제한- 대용량 데이터 조회 시 메모리 부족 방지

- SETTINGS 옵션 설명

- max_memory_usage - 쿼리 실행 시 최대 메모리 사용량 제한

- 1000000000 - 1GB (1,000,000,000 bytes)

- 효과 - 메모리 한계 도달 시 자동으로 디스크 사용

- 동작 방식

- 메모리에서 처리 (빠름)

- 메모리 1GB 도달 시

- 임시 파일로 스왑 (느리지만 안전)

- 스트리밍으로 결과 반환

ClickHouse SQL 핵심 요약

기능 사용 시점 성능 효과 ARRAY JOIN 배열을 행으로 펼칠 때 복잡한 배열 분석 가능 dictGet() 마스터 데이터 테이블 빈번 조회 JOIN 대비 10-50배 빠름 WITH TOTALS 소계가 필요한 리포트 별도 쿼리 불필요 LIMIT BY 각 그룹별 상위 N개만 필요할 때 데이터량 대폭 감소 FINAL ReplacingMergeTree에서 최신 데이터만 필요할 때 중복 제거 보장 실무에서 자주 하는 실수들

불필요한 ARRAY JOIN 남발

has(),arrayExists()함수로 대체 가능한 경우가 많다.- 판별 기준은 "배열 요소별 상세 분석"이 아니라 "존재 여부만 확인"이면

has()계열 사용하는 것이 좋다

FINAL을 모든 쿼리에 사용

- 성능 저하 원인, 정말 필요한 경우만 사용

딕셔너리 설정 없이 반복 JOIN

- 자주 조회하는 마스터 테이블은 반드시 딕셔너리로 구성

- 기준

- 조회 빈도 >100회/시간 → 딕셔너리 필수

- 조회 빈도 >마스터 테이블 크기 < 10만 건 → 딕셔너리 적합

- 변경 빈도 < 1회/일 → 딕셔너리 적합

- 예시

- ICD-10 진단코드

- 약품 마스터

- 부서/지역 코드

- 고객 등급 코드

최적화 팁

- "찾기"가 목적이면 →

has(),hasAny(),arrayExists()계열 함수 사용 - "변환"이 목적이면 →

dictGet()또는arrayMap()활용 - "분석"이 목적이면 →

ARRAY JOIN+ 집계 함수 조합 - 자주 쓰는 마스터 테이블 → 반드시 딕셔너리로 구성 (조회 빈도 > 100회/시간)

- 배열 크기 > 10개 →

arraySlice()로 메모리 사용량 주의 - 대용량 결과셋 →

SETTINGS max_memory_usage제한 설정 - ReplacingMergeTree → 정말 필요한 경우만

FINAL사용 - 마스터 테이블 크기 < 10만 건 → 딕셔너리 최적화 대상

- "찾기"가 목적이면 →

상세 설명

분산 시스템의 핵심 - ZooKeeper (ZK)

ZooKeeper는 분산 시스템의 메타데이터와 설정 정보를 중앙에서 관리하는 서비스이다.

ClickHouse 클러스터에서 ZooKeeper 역할

복제 테이블 메타데이터 관리

ReplicatedMergeTree테이블의 모든 메타데이터를 중앙 저장소에 보관- 각 데이터 파티션이 어떤 노드에 있는지 실시간 추적

- 클러스터에 속한 모든 노드의 구성 정보와 상태 관리

- 노드가 추가/제거될 때 클러스터 토폴로지 자동 업데이트

데이터 복제 조정 (Replication Coordination)

ReplicatedMergeTree에서 새 데이터 INSERT 시 모든 레플리카에 복제 지시- 각 레플리카의 복제 진행 상황과 지연(lag) 모니터링

- 복제 실패 시 재시도 큐(queue) 관리

- 노드 장애 시 다른 레플리카로 자동 페일오버

분산 DDL 동기화

ON CLUSTER명령어 실행 시 모든 노드에 순차적/병렬 실행 조정- CREATE/ALTER/DROP TABLE 같은 스키마 변경사항 동기화

- DDL 실행 성공/실패 상태를 추적하고 롤백 관리

- 예시 :

CREATE TABLE ON CLUSTER my_cluster는 ZooKeeper를 통해 모든 노드에 전파

분산 작업 충돌 방지와 리더 선출

- 백그라운드 Merge 작업을 수행할 리더 노드 선출

- 동일한 파티션에 대한 동시 작업 방지 (분산 락)

- 여러 노드가 동시에 같은 데이터를 수정하려 할 때 순서 보장

- Part 이동, 파티션 드롭 등 위험한 작업의 원자성 보장

클러스터 상태 모니터링과 헬스체크

- 각 노드의 생존 상태를 주기적으로 체크 (하트비트)

- 노드 다운 감지 시 클러스터에서 자동 제외

- 복구된 노드의 클러스터 재진입 관리

- 쿼럼(Quorum) 기반 의사결정으로 스플릿 브레인 방지

최신 트렌드 : ClickHouse Keeper

2022년부터 C++로 작성된 ClickHouse Keeper가 production-ready가 되었다

주요 개선사항

- C++로 작성되어 ClickHouse와 네이티브 통합되어 신규 구축 시 Keeper 사용을 권장한다.

- 메모리 사용량 46배 감소, I/O 8배 개선

- ZooKeeper와 프로토콜 호환 (설정만 바꾸면 전환 가능)

- Java GC 문제 완전 해결

현재 상황

- ClickHouse Cloud는 모두 Keeper 사용

- 신규 온프레미스 구축도 Keeper 권장

- 기존 ZooKeeper 사용자는 설정 파일만 변경하면 전환 가능

데이터 분산의 두 축 - 샤드와 레플리카

샤드(Shard) - 수평 분할

- 데이터를 여러 서버에 나누어 저장

- 각 샤드는 전체 데이터의 일부분만 저장 ⇒ 전체 데이터셋을 나누어 저장

- 샤드 수를 늘리면 저장 용량과 처리 성능이 선형적으로 증가

- 목적 : 데이터 양이 너무 많아 한 서버에 다 못 담거나, 병렬 처리로 성능 향상

- 예:

- 회원 ID 1~1,000,000 → Shard 1

- 회원 ID 1,000,001~2,000,000 → Shard 2

레플리카(Replica) - 복제본

- 같은 샤드의 모든 레플리카는 완전히 동일한 데이터 보유

- 한 레플리카가 다운되어도 서비스 중단 없음 (High Availability)

- 읽기 요청을 여러 레플리카로 부하 분산 가능

- 쓰기는 모든 레플리카에 전파되어야 하므로 쓰기 성능은 향상되지 않음

- 목적 : 장애 복구(HA) + 읽기 부하 분산

ClickHouse 샤드 & 리플리카 구조 예시

의료 데이터 클러스터 (환자 1억 명, 진료기록 10억 건) │ ├─ Shard 1 (환자 1~3,300만) │ ├─ Replica 1 [서버 A] - 마스터 역할 │ ├─ Replica 2 [서버 B] - 읽기 전용 │ └─ Replica 3 [서버 C] - 백업/재해복구용 │ ├─ Shard 2 (환자 3,300만~6,600만) │ ├─ Replica 1 [서버 D] │ ├─ Replica 2 [서버 E] │ └─ Replica 3 [서버 F] │ └─ Shard 3 (환자 6,600만~1억) ├─ Replica 1 [서버 G] ├─ Replica 2 [서버 H] └─ Replica 3 [서버 I] 총 9대 서버 = 3 샤드 × 3 레플리카- 샤드와 레플리카 수 결정 기준

- 샤드 수 = 데이터 총량 ÷ 서버당 저장 가능 용량

- 1TB 데이터, 서버당 200GB 가능 ⇒ 최소 5개 샤드 필요

- 레플리카 수 = 가용성 요구사항 + 읽기 부하

- 일반 서비스 : 2개 (마스터 + 백업)

- 중요 서비스 : 3개 (과반수 쿼럼 확보)

- 읽기 많은 서비스 : 4개 이상

- 샤드 수 = 데이터 총량 ÷ 서버당 저장 가능 용량

- 샤드와 레플리카 수 결정 기준

샤드(Shard) vs 파티션(Partition) 차이

구분 샤드(Shard) 파티션(Partition) 개념 데이터를 여러 서버에 분산 데이터를 한 서버 내에서 분할 위치 물리적으로 다른 서버/노드 같은 서버의 다른 디렉토리/파일 목적 수평 확장(Scale-out) 쿼리 최적화, 데이터 관리 확장성 서버 추가로 무한 확장 가능 단일 서버 용량에 제한 장애 영향 샤드 하나 다운 시 일부 데이터만 영향 서버 다운 시 모든 파티션 영향 ClickHouse 예시 Distributed테이블로 구현PARTITION BY toYYYYMM(date)

클러스터 아키텍처 설계

실무에서는 수십 대의 서버로 클러스터를 구성하는 경우도 있다

개발 환경에서 Docker Compose로 최소 구성을 만들어 동작 원리를 학습하는 것이 이번 장의 목적이다

docker-compose-cluster.yml

version: '3.8' services: # ZooKeeper - 클러스터 메타데이터 관리 zookeeper: image: confluentinc/cp-zookeeper:latest hostname: zookeeper container_name: zookeeper ports: - "2181:2181" environment: ZOOKEEPER_CLIENT_PORT: 2181 ZOOKEEPER_TICK_TIME: 2000 volumes: - zk-data:/var/lib/zookeeper/data - zk-logs:/var/lib/zookeeper/log # ClickHouse 노드 1 clickhouse-01: image: clickhouse/clickhouse-server:latest hostname: clickhouse-01 container_name: clickhouse-01 ports: - "8123:8123" - "9000:9000" volumes: - ch01-data:/var/lib/clickhouse - ./cluster-config/clickhouse-01:/etc/clickhouse-server/config.d - ./cluster-config/users:/etc/clickhouse-server/users.d depends_on: - zookeeper ulimits: nofile: soft: 262144 hard: 262144 # ClickHouse 노드 2 clickhouse-02: image: clickhouse/clickhouse-server:latest hostname: clickhouse-02 container_name: clickhouse-02 ports: - "8124:8123" - "9001:9000" volumes: - ./cluster-config/clickhouse-02:/etc/clickhouse-server/config.d - ./cluster-config/users:/etc/clickhouse-server/users.d - ch02-data:/var/lib/clickhouse depends_on: - zookeeper ulimits: nofile: soft: 262144 hard: 262144 volumes: zk-data: zk-logs: ch01-data: ch02-data:zookeeper 설정 상세 설명

zookeeper: image: confluentinc/cp-zookeeper:latest hostname: zookeeper container_name: zookeeper ports: - "2181:2181" environment: ZOOKEEPER_CLIENT_PORT: 2181 ZOOKEEPER_TICK_TIME: 2000 volumes: - zk-data:/var/lib/zookeeper/data - zk-logs:/var/lib/zookeeper/log- image: confluentinc/cp-zookeeper:latest

- Kafka를 개발한 Confluent에서 제공하는 안정화된 ZooKeeper 이미지

- 포트 : 2181

- ZooKeeper 기본 클라이언트 포트

- environment

ZOOKEEPER_CLIENT_PORT: 2181 # 클라이언트 연결 포트 ZOOKEEPER_TICK_TIME: 2000 # 기본 시간 단위 (밀리초)- 기본 시간 단위 : 2초

- 하트비트, 타임아웃, 세션 관리의 기준 시간

- 세션 타임아웃이 6 tick이면 12초 (2000ms × 6)

- Session Timeout : 기본적으로 6 tick

- Connection Timeout : 기본적으로 2 tick

- Sync Limit : 기본적으로 5 tick

tick: ZooKeeper의 기본 시간 단위

- volumes (데이터 영속화)

volumes: - zk-data:/var/lib/zookeeper/data # 클러스터 메타데이터 저장 - zk-logs:/var/lib/zookeeper/log # 트랜잭션 로그 저장- 데이터 유실 방지

- 메타데이터 보관

- image: confluentinc/cp-zookeeper:latest

각 노드 설정

- 각 노드의 포트 설정

clickhouse-01: ... ports: - "8123:8123" # HTTP 포트 - "9000:9000" # TCP 포트 clickhouse-02: ... ports: - "8124:8123" - "9001:9000" - depends_on 설정

depends_on: - zookeeper # ZooKeeper가 먼저 시작되어야 한다- 시작 순서 제어

- ZooKeeper → ClickHouse 노드 순서로 시작

- 의존성

- ClickHouse가 ZooKeeper 없이는 동작할 수 없음을 명시

- 시작 순서 제어

- 각 노드의 포트 설정

샤드와 레플리카 설정 구성

cluster-config/clickhouse-01/cluster.xml

<?xml version="1.0"?> <clickhouse> <!-- 클러스터 정의 --> <remote_servers> <medical_cluster> <shard> <replica> <host>clickhouse-01</host> <port>9000</port> <user>admin</user> <password>1234</password> </replica> <replica> <host>clickhouse-02</host> <port>9000</port> <user>admin</user> <password>1234</password> </replica> </shard> </medical_cluster> </remote_servers> <!-- ZooKeeper 설정 --> <zookeeper> <node> <host>zookeeper</host> <port>2181</port> </node> </zookeeper> <!-- 매크로 설정 (각 노드별로 다름) --> <macros> <cluster>medical_cluster</cluster> <shard>01</shard> <replica>clickhouse-01</replica> </macros> <!-- 네트워크 설정 --> <listen_host>0.0.0.0</listen_host> <http_port>8123</http_port> <tcp_port>9000</tcp_port> </clickhouse>클러스터 설정과 ZooKeeper 설정

medical_cluster └── shard 1 ├── replica 1 (clickhouse-01) ← 같은 데이터 └── replica 2 (clickhouse-02) ← 같은 데이터 (백업)클러스터 연결 설정

<remote_servers> <medical_cluster> <shard> <replica> <host>clickhouse-01</host> <port>9000</port> <user>admin</user> <password>1234</password> </replica> <replica> <host>clickhouse-02</host> <port>9000</port> <user>admin</user> <password>1234</password> </replica> </shard> </medical_cluster> </remote_servers>클러스터 통신은 TCP만 사용 (노드간 통신)

- 데이터 복제 (Binary 프로토콜 필요)

- 메타데이터 동기화 (고성능 필요)

- 클러스터 상태 체크 (실시간성 필요)

- 분산 쿼리 실행 (최적화된 프로토콜 필요)

HTTP는 부적합한 이유

- 오버헤드

- TCP 대비 느림

- 바이너리 데이터 전송 어려움

실제 통신 시나리오

사용자 → localhost:8124 (HTTP) → clickhouse-02:8123 → ClickHouse HTTP 서버 사용자 → localhost:9001 (TCP) → clickhouse-02:9000 → ClickHouse TCP 서버 clickhouse-01 → clickhouse-02:9000 (TCP) → ClickHouse TCP 서버

ZooKeeper 연결 설정

<zookeeper> <node> <host>zookeeper</host> <port>2181</port> </node> </zookeeper>- 메타데이터 저장소, 리더 선출, 장애 감지

매크로 설정 (노드별 고유값)

<macros> <cluster>medical_cluster</cluster> <shard>01</shard> <replica>clickhouse-01</replica> </macros>

클러스터 네트워크 구성과 포트 설정

listen_host: 0.0.0.0: 모든 IP에서 접속 허용 (컨테이너 환경에서 필수)<http_port>8123</http_port>: HTTP 포트 (DBeaver, API 접근)<tcp_port>9000</tcp_port>: Native TCP 포트 (노드간 통신, 고성능)<replica> <host>clickhouse-01</host> <port>9000</port> </replica>- 2개의 포트가 일치하지 않으면 연결 실패 !

- 클러스터 필수 (노드 간 통신)

2181: ZooKeeper 포트 (메타데이터 동기화)

포트 3층 구조

외부 접근 포트 → Docker 매핑 → ClickHouse 내부 포트

9001 → 9000 → 9000

외부 접근 포트 : 9001

- 역할

- 호스트 머신에서 컨테이너로 들어가는 관문

- 사용자

- 외부 클라이언트, 개발자

- 예시

clickhouse-client --host localhost --port 9001

- 역할

Docker 컨테이너 포트 : 9000

- 역할

- Docker 네트워크 내부에서 컨테이너가 받는 포트

- 사용자

- Docker 네트워크, 다른 컨테이너

- 예시

- 컨테이너 간 통신 시

clickhouse-02:9000

- 컨테이너 간 통신 시

- 역할

ClickHouse 애플리케이션 포트 : 9000

- 역할

- ClickHouse 서버가 실제로 리스닝하는 포트

- 설정

<tcp_port>9000</tcp_port>

- 사용자

- ClickHouse 프로세스 자체

- 역할

매크로란 무엇인가?

매크로는 변수 같은 개념으로, SQL 실행 시점에 실제 값으로 대체된다.

매크로 사용 이유

매크로 없이 하면 각 노드마다 다른 SQL 작성해야 한다.

-- clickhouse-01 ENGINE = ReplicatedMergeTree('/clickhouse/tables/01/patients', 'clickhouse-01') -- clickhouse-02 ENGINE = ReplicatedMergeTree('/clickhouse/tables/01/patients', 'clickhouse-02')매크로는 같은 SQL로 다른 노드에서 다른 설정을 만들기 위한 템플릿 시스템

ENGINE = ReplicatedMergeTree('/clickhouse/tables/{shard}/patients', '{replica}')

매크로 설정 (각 노드별)

clickhouse-01의 cluster.xml

<macros> <cluster>medical_cluster</cluster> <shard>01</shard> <replica>clickhouse-01</replica> </macros>clickhouse-02의 cluster.xml

<macros> <cluster>medical_cluster</cluster> <shard>01</shard> <replica>clickhouse-02</replica> </macros><shard>- 샤드 번호 : 같은 데이터 그룹

<replica>- 레플리카 ID : 노드 고유 식별자

치환 과정 단계별 설명

1단계 : 원본 SQL

CREATE TABLE medical.patients_replica ON CLUSTER medical_cluster ENGINE = ReplicatedMergeTree('/clickhouse/tables/{shard}/patients', '{replica}'){shard}: 매크로 (아직 변수 상태){replica}: 매크로 (아직 변수 상태)

2단계 : ON CLUSTER 명령어의 동작

이 명령어는 클러스터의 모든 노드에서 동시에 실행되지만, 각 노드에서는 자신의 매크로 값으로 치환된다.

clickhouse-01에서 실행될 때

ENGINE = ReplicatedMergeTree('/clickhouse/tables/01/patients', 'clickhouse-01'){shard}⇒ 01 치환- cluster.xml의

<shard>01</shard>

- cluster.xml의

{replica}⇒ clickhouse-01 치환- cluster.xml의

<replica>clickhouse-01</replica>

- cluster.xml의

clickhouse-02에서 실행될 때

ENGINE = ReplicatedMergeTree('/clickhouse/tables/01/patients', 'clickhouse-02'){shard}⇒ 01 치환{replica}⇒ clickhouse-02 치환

매크로 핵심 사항

- 같은 SQL 명령어가 각 노드에서 동일하게 실행

- 단, 개별 매크로 값으로 치환되어 각기 다른 결과 생성

- ZooKeeper 경로는 동일 (

/clickhouse/tables/01/patients) ⇒ 복제 관계 형성 - 레플리카 식별자는 다름 ⇒ 노드 구분

clickhouse-01vsclickhouse-02

ReplicatedMergeTree가 필요한 이유

MergeTree vs ReplicatedMergeTree

일반 MergeTree (단일 노드용)

ENGINE = MergeTree() ORDER BY patient_id- 문제점 : 한 노드에만 데이터 저장

- 위험 : 노드 장애 시 데이터 유실

- 제한 : 확장성 없음

ReplicatedMergeTree (클러스터용)

ENGINE = ReplicatedMergeTree('/clickhouse/tables/{shard}/patients', '{replica}') ORDER BY patient_id- 장점 : 여러 노드에 동일 데이터 복제

- 안정성 : 노드 장애 시에도 데이터 보존

- 확장성 : 읽기 성능 향상

ReplicatedMergeTree 매개변수

앞서 설명한 매크로를 활용하여 ReplicatedMergeTree를 설정

ReplicatedMergeTree('/clickhouse/tables/{shard}/patients', '{replica}') ↑ ↑ ZooKeeper 경로 레플리카 식별자ZooKeeper 경로 :

/clickhouse/tables/{shard}/patients- 매크로 치환 결과 :

/clickhouse/tables/01/patients - 복제본들이 메타데이터를 공유하는 논리적 경로

- 매크로 치환 결과 :

레플리카 식별자 :

{replica}- 매크로 치환 결과 :

clickhouse-01,clickhouse-02 - 각 노드를 구분하는 고유 ID

- 매크로 치환 결과 :

ZooKeeper 내부 구조

ReplicatedMergeTree가 ZooKeeper에서 복제를 관리하는 방식

/clickhouse/tables/01/patients/ ├── replicas/ │ ├── clickhouse-01/ ← 노드1 정보 │ └── clickhouse-02/ ← 노드2 정보 ├── blocks/ ← 공유 메타데이터 └── mutations/ ← 공유 작업 정보- 이것은 물리적 파일 경로가 아니라 ZooKeeper 내부의 논리적 경로이다

- 같은 테이블의 복제본들이 같은 ZooKeeper 경로를 공유

- 메타데이터와 복제 상태를 함께 관리

데이터 삽입 시 동작 과정

데이터 삽입 시

clickhouse-01에 데이터 삽입

INSERT INTO patients_replica VALUES ('P001', '김철수', ...);ZooKeeper 경로에 메타데이터 기록

/clickhouse/tables/01/patients/blocks/block_12345- 새로운 데이터 블록 정보가 ZooKeeper에 기록된다.

- 두 노드가 모두 이 경로를 감시하고 있다

clickhouse-02가 변경 감지 ⇒ "어?

/clickhouse/tables/01/patients에 새 블록 정보가 생겼네!"⇒ clickhouse-01에서 데이터 복사 시작

복제 완료 후 상태 업데이트

/clickhouse/tables/01/patients/replicas/clickhouse-01/block_12345_synced /clickhouse/tables/01/patients/replicas/clickhouse-02/block_12345_synced

실제 파일 저장 위치 vs ZooKeeper 경로

실제 데이터 파일 저장 위치

실제 파일 : 각 노드의 로컬 디스크에 별도 저장

clickhouse-01

/var/lib/clickhouse/data/medical/patients_replica/ ├── 202401_1_1_0/ ← 2024년 1월 파티션 ├── 202402_2_2_0/ ← 2024년 2월 파티션 └── ...clickhouse-02

/var/lib/clickhouse/data/medical/patients_replica/ ├── 202401_1_1_0/ ← 동일한 데이터 (복제됨) ├── 202402_2_2_0/ ← 동일한 데이터 (복제됨) └── ...

ZooKeeper 메타데이터 경로

/clickhouse/tables/01/patients/ ← 이 경로는 "공유 관리 공간"- 역할 : 두 노드가 복제 상태를 조정하기 위한 공통 관리 공간

복제 테이블 생성과 매크로 활용

클러스터에서는 일반 MergeTree 대신 ReplicatedMergeTree를 사용하여 데이터 복제를 보장한다.

신규 데이터베이스 생성

CREATE DATABASE medical ON CLUSTER medical_cluster;복제 테이블 생성

CREATE TABLE medical.patients_replica ON CLUSTER medical_cluster ( patient_id String, name String, birth_date Date, gender Enum8('M' = 1, 'F' = 2), phone String, registration_date DateTime DEFAULT now(), updated_at DateTime DEFAULT now() ) ENGINE = ReplicatedMergeTree('/clickhouse/tables/{shard}/patients', '{replica}') ORDER BY patient_id PARTITION BY toYYYYMM(registration_date);- 양쪽 노드에서 자동으로 테이블이 생성되며, ZooKeeper를 통해 복제 관계가 설정된다.

- 핵심 포인트

ON CLUSTER medical_cluster- 클러스터 모든 노드에서 동시 실행

/clickhouse/tables/{shard}/patients- ZooKeeper 경로 (매크로 사용)

{replica}- 각 노드의 고유 식별자

Distributed 테이블이 필요한 이유

ReplicatedMergeTree vs Distributed 역할 구분

- 실제 데이터 저장 (ReplicatedMergeTree) clickhouse-01 : patients_replica (환자 1-50만) clickhouse-02 : patients_replica (환자 1-50만) ← 복제본 - 클라이언트 접근점 (Distributed) patients_distributed → 모든 샤드를 하나의 테이블처럼 통합ReplicatedMergeTree (데이터 저장층)

- 역할 : 실제 데이터를 저장하고 복제 관리

- 특징 : 노드 간 데이터 복제, 장애 복구

- 사용 : 일반적으로는 직접 접근하지 않고 Distributed를 통해 접근

Distributed (클라이언트 접근층)

- 역할 : 여러 샤드의 데이터를 하나의 테이블처럼 통합 제공

- 특징 : 샤딩 로직, 분산 쿼리 처리

- 사용 : 애플리케이션에서 실제로 INSERT/SELECT하는 테이블

왜 Distributed가 필요한가?

Distributed 없이 직접 접근할 때의 문제점

문제점 1 : 어느 노드에 데이터가 있는지 모른다

SELECT * FROM patients_replica WHERE patient_id = 'P12345';- 이 환자가 어느 노드에 있는지 개발자가 직접 찾아야 한다.

문제점 2 : 전체 데이터 조회가 불가능

SELECT COUNT(*) FROM patients_replica;- 한 노드의 데이터만 집계된다, 전체 집계 불가능

문제점 3 : 샤드별로 따로 INSERT 해야 한다

- 개발자가 직접 샤딩 로직을 구현해야 한다

Distributed로 해결

해결 1 : 자동으로 모든 샤드 검색

SELECT * FROM patients_distributed WHERE patient_id = 'P12345';- ClickHouse가 자동으로 모든 노드를 검색해서 결과 반환

해결 2 : 전체 데이터 통합 조회

SELECT COUNT(*) FROM patients_distributed;- 모든 샤드의 데이터를 자동 집계

해결 3 : 자동 샤딩

INSERT INTO patients_distributed VALUES (...);- 샤딩 키에 따라 자동으로 적절한 노드에 분산 저장

분산 테이블 생성과 매개변수

분산 테이블 생성

CREATE TABLE medical.patients_distributed ON CLUSTER medical_cluster ( patient_id String, name String, birth_date Date, gender Enum8('M' = 1, 'F' = 2), phone String, registration_date DateTime DEFAULT now(), updated_at DateTime DEFAULT now() ) ENGINE = Distributed('medical_cluster', 'medical', 'patients_replica', rand());- 앞서 생성한 ReplicatedMergeTree 위에 Distributed 레이어를 구성한다.

Distributed 엔진 매개변수 ⭐

Distributed('medical_cluster', 'medical', 'patients_replica', rand()) ↑ ↑ ↑ ↑ 클러스터 이름 데이터베이스 실제 테이블 샤딩 키- 클러스터 이름

medical_cluster- cluster.xml에서 정의한 이름

- 데이터베이스

medical- 실제 데이터가 있는 데이터베이스

- 실제 테이블

patients_replica- ReplicatedMergeTree 테이블

- 샤딩 키

- 데이터 분산 방식 결정

- 예시)

rand()

- 클러스터 이름

샤딩 키 선택과 데이터 분산 전략

샤딩 키는 데이터가 어느 샤드에 저장될지 결정하는 핵심 요소이다.

랜덤 분산 (

rand())ENGINE = Distributed('medical_cluster', 'medical', 'patients_replica', rand());장점

- 데이터가 모든 샤드에 균등하게 분산

단점

- 특정 데이터 조회 시 모든 샤드를 검색해야 한다

적합한 경우

- 집계 쿼리가 많고, 특정 레코드 조회가 적은 경우

실제 분산 결과

Shard 1: 환자 P001, P005, P007, P012... (랜덤) Shard 2: 환자 P002, P004, P008, P015... (랜덤)

해시 기반 분산 (

cityHash64(키))ENGINE = Distributed('medical_cluster', 'medical', 'patients_replica', cityHash64(patient_id));장점

- 동일한 키는 항상 같은 샤드에 저장

단점

- 데이터 분산이 불균등할 수 있음

적합한 경우

- 특정 환자의 모든 데이터를 자주 조회하는 경우

실제 분산 결과

Shard 1: 환자 P001, P003, P005... (해시값 기준) Shard 2: 환자 P002, P004, P006... (해시값 기준)

날짜 기반 분산 (

toYYYYMM())ENGINE = Distributed('medical_cluster', 'medical', 'patients_replica', toYYYYMM(registration_date));장점

- 특정 기간 조회 시 해당 샤드만 접근

단점

- 최신 데이터가 한 샤드에 집중될 수 있다

적합한 경우

- 시계열 분석이 많은 경우

실제 분산 결과

Shard 1: 2024년 1월 등록 환자들 Shard 2: 2024년 2월 등록 환자들

분산 쿼리 실행 과정

SELECT 쿼리 실행 과정

SELECT gender, COUNT(*) as patient_count, AVG(dateDiff('year', birth_date, now())) as avg_age FROM medical.patients_distributed WHERE registration_date >= '2024-01-01' GROUP BY gender;1단계 : 쿼리 계획 수립

- Query Coordinator (접속한 노드)

- 분산 쿼리 실행 시 최초로 클라이언트가 연결한 ClickHouse 노드

- Query Coordinator가 설정 파일을 보고 "이 쿼리를 모든 샤드에서 실행해야겠다"고 생각

- 쿼리 계획 수립과 하위 쿼리 분배를 담당

- Query Coordinator (접속한 노드)

2단계 : 각 샤드에 하위 쿼리 전송

clickhouse-01에 전송

SELECT gender, COUNT(*) as patient_count, AVG(...) as avg_age FROM medical.patients_replica WHERE registration_date >= '2024-01-01' GROUP BY gender;clickhouse-02에 전송

SELECT gender, COUNT(*) as patient_count, AVG(...) as avg_age FROM medical.patients_replica WHERE registration_date >= '2024-01-01' GROUP BY gender;- 동일한 쿼리

3단계 : 각 샤드에서 부분 결과 반환

clickhouse-01 결과

M 150 32.5 F 200 29.8clickhouse-02 결과

M 180 31.2 F 170 30.1- 동일한 쿼리

4단계 : 결과 병합 및 최종 집계

최종 결과

M 330 31.8 ← (150+180, (32.5*150+31.2*180)/(150+180)) F 370 29.9 ← (200+170, (29.8*200+30.1*170)/(200+170))

INSERT vs SELECT 동작 방식

INSERT 동작 (샤딩 키에 따른 분산)

INSERT INTO medical.patients_distributed VALUES ('P12345', '김철수', '1990-05-15', 'M', '010-1234-5678', now(), now());동작 과정

- 샤딩 키 계산

rand()실행 ⇒ 예 :0.7234

- 샤드 선택

0.7234 * 샤드수(2) = 1.4468⇒ 두 번째 샤드 선택

- 해당 샤드에만 INSERT

- clickhouse-02의 patients_replica에만 저장

- 복제 자동 실행

- ReplicatedMergeTree에 의해 자동 복제

- 샤딩 키 계산

INSERT 결과

clickhouse-01: patients_replica (복제본으로 저장됨) clickhouse-02: patients_replica (원본으로 저장됨)

SELECT 동작 (모든 샤드 조회)

SELECT * FROM medical.patients_distributed WHERE patient_id = 'P12345';- 동작 과정

- 모든 샤드에 쿼리 전송

- 데이터가 어디 있는지 모르기 때문에 모든 샤드에 전송한다.

- 각 샤드에서 검색

clickhouse-01: 결과 없음clickhouse-02: 김철수 데이터 반환

- 결과 병합

- 김철수 데이터만 최종 반환

- 모든 샤드에 쿼리 전송

- 동작 과정

클러스터 환경에서의 쿼리 최적화

WHERE 절 최적화 (파티션 프루닝)

비효율적 : 모든 샤드, 모든 파티션 스캔

SELECT * FROM orders_distributed WHERE customer_name = '김철수';- 이 경우는 샤드 키가

rand()와 같이 샤드 프루닝은 없는 경우이다. - 모든 샤드에 쿼리가 전송되어 불필요한 리소스 소모

- 이 경우는 샤드 키가

효율적 : 특정 파티션만 스캔

SELECT * FROM orders_distributed WHERE order_date >= '2024-01-01' AND order_date < '2024-02-01' AND customer_name = '김철수';- 파티션 프루닝 ⇒ 불필요한 데이터 블록 스킵

- 즉, 불필요한 노드 접근을 차단하여 성능 대폭 향상

GLOBAL JOIN 사용 ⭐

비효율적 : 일반 JOIN

SELECT o.order_id, o.customer_id, c.customer_count FROM orders_distributed o JOIN ( SELECT customer_id, COUNT(*) as customer_count FROM orders_distributed GROUP BY customer_id ) c ON o.customer_id = c.customer_id;- 각 샤드에서 개별적으로 JOIN 수행

- 이 경우 네트워크 트래픽 폭증 및 중복 계산이 발생 될 수 있다.

효율적 : GLOBAL JOIN

SELECT o.order_id, o.customer_id, c.customer_count FROM orders_distributed o GLOBAL JOIN ( SELECT customer_id, COUNT(*) as customer_count FROM orders_distributed GROUP BY customer_id ) c ON o.customer_id = c.customer_id;- 서브쿼리 결과를 한 번만 계산

- 모든 샤드에 브로드캐스트하여 네트워크 효율성 극대화

집계 쿼리 최적화

최적화된 집계 쿼리

SELECT toYYYYMM(order_date) as month, status, COUNT(*) as order_count, uniq(customer_id) as unique_customers, sum(amount) as total_amount FROM orders_distributed WHERE order_date >= '2024-01-01' GROUP BY month, status ORDER BY month DESC SETTINGS distributed_group_by_no_merge = 1, max_distributed_connections = 10, max_threads = 4;- 로컬 집계 최적화

distributed_group_by_no_merge = 1- 각 샤드에서 로컬 집계 후 병합

- 병렬 연결 수 제한

max_distributed_connections = 10- 동시 연결 수 제한

- 스레드 수 제한

max_threads = 4- CPU 리소스 관리

- 로컬 집계 최적화

GROUP BY 최적화

로컬 집계 후 글로벌 병합

-- 대용량 데이터 집계 시 최적화 SELECT product_category, avg(price) as avg_price, count() as product_count FROM products_distributed GROUP BY product_category SETTINGS distributed_group_by_no_merge = 1, group_by_two_level_threshold = 100000;동작 방식

- 각 샤드에서 로컬 GROUP BY 실행

- 중간 결과를 코디네이터 노드로 전송

- 최종 GROUP BY로 결과 병합

장점

- 네트워크 트래픽 대폭 감소

- 메모리 사용량 효율적 관리

- ORDER BY 최적화

LIMIT와 함께 사용하여 중간 결과 크기 제한

-- TOP 100 주문만 조회 SELECT order_id, customer_id, amount, order_date FROM orders_distributed WHERE order_date >= '2024-01-01' ORDER BY amount DESC LIMIT 100 SETTINGS max_bytes_before_external_sort = 1000000000;동작 방식

- 각 샤드에서 TOP 100 선별

- 샤드별 결과를 코디네이터로 전송 (최대 샤드수 × 100개)

- 최종 정렬하여 TOP 100 반환

장점

- 전체 데이터 정렬 없이 효율적 TOP-N 조회

- 메모리 사용량 예측 가능

실무 성능 튜닝

INSERT 최적화

배치 INSERT로 성능 향상

비효율적 : 단건 INSERT

INSERT INTO orders_distributed VALUES ('O001', 'C001', 1000, now()); INSERT INTO orders_distributed VALUES ('O002', 'C002', 2000, now()); INSERT INTO orders_distributed VALUES ('O003', 'C003', 3000, now());효율적 : 배치 INSERT

INSERT INTO orders_distributed VALUES ('O001', 'C001', 1000, now()), ('O002', 'C002', 2000, now()), ('O003', 'C003', 3000, now()), ('O004', 'C004', 4000, now());

비동기 INSERT 설정

비동기 INSERT로 응답 시간 단축

SET insert_distributed_sync = 0; -- 비동기 모드 SET insert_distributed_timeout = 0; -- 타임아웃 무제한 SET async_insert = 1; -- 비동기 배치 처리 SET wait_for_async_insert = 0; -- 완료 대기 안함 INSERT INTO orders_distributed VALUES ('O001', 'C001', 1000, now()), ('O002', 'C002', 2000, now());- 장점 : 클라이언트 응답 시간 대폭 단축

- 주의점 : 데이터 일관성 체크 필요

SELECT 최적화

쿼리 캐시 활용

자주 조회하는 대시보드 쿼리

SELECT toStartOfHour(order_date) as hour, status, COUNT(*) as order_count, sum(amount) as total_amount FROM orders_distributed WHERE order_date >= now() - INTERVAL 24 HOUR GROUP BY hour, status ORDER BY hour DESC SETTINGS use_query_cache = 1, -- 쿼리 캐시 활성화 query_cache_ttl = 300; -- 5분 캐시- 효과 : 동일 쿼리 100-1000배 빠름

- 적용 대상 : 실시간 대시보드, 정기 리포트

메모리 사용량 제한

대용량 데이터 분석 시 메모리 관리

SELECT customer_id, count() as order_count, sum(amount) as total_amount FROM orders_distributed WHERE order_date >= '2023-01-01' GROUP BY customer_id SETTINGS max_memory_usage = 2000000000, -- 2GB 제한 max_bytes_before_external_group_by = 1000000000; -- 1GB 초과시 디스크 사용- 동작 : 메모리 한계 도달 시 자동으로 디스크 사용

- 장점 : 대용량 쿼리도 안정적 실행

복잡한 분석 쿼리

고객 세그먼트별 주문 패턴 분석

SELECT multiIf( total_orders < 5, 'New Customer', total_orders < 20, 'Regular Customer', total_orders < 50, 'VIP Customer', 'Premium Customer' ) as customer_segment, count() as customer_count, avg(avg_order_amount) as segment_avg_amount, sum(total_amount) as segment_total_revenue FROM ( SELECT customer_id, count() as total_orders, avg(amount) as avg_order_amount, sum(amount) as total_amount FROM orders_distributed WHERE order_date >= '2024-01-01' GROUP BY customer_id ) GROUP BY customer_segment ORDER BY segment_total_revenue DESC SETTINGS distributed_group_by_no_merge = 1, max_threads = 8;- 최적화 포인트

- 서브쿼리에서 먼저 고객별 집계

- 외부 쿼리에서 세그먼트별 재집계

- 분산 GROUP BY 최적화 적용

- 최적화 포인트

클러스터 모니터링과 관리

클러스터 상태 확인

분산 테이블 정보 확인

SELECT cluster, shard_num, replica_num, host_name, port, is_local FROM system.clusters WHERE cluster = 'orders_cluster';샤드별 데이터 분포 확인

SELECT hostName() as host, COUNT(*) as record_count, min(order_date) as min_date, max(order_date) as max_date, formatReadableSize(sum(bytes_on_disk)) as data_size FROM orders_replica GROUP BY host ORDER BY record_count DESC;

성능 메트릭 모니터링

쿼리 성능 통계

SELECT query_kind, count() as query_count, avg(query_duration_ms) as avg_duration, max(query_duration_ms) as max_duration, avg(read_rows) as avg_rows_read, avg(memory_usage) as avg_memory FROM system.query_log WHERE event_date = today() AND query LIKE '%orders_distributed%' AND query_duration_ms > 1000 -- 1초 이상 쿼리만 GROUP BY query_kind ORDER BY avg_duration DESC;느린 쿼리 TOP 10

SELECT query, query_duration_ms, memory_usage, read_rows, written_rows, event_time FROM system.query_log WHERE event_date = today() AND type = 'QueryFinish' ORDER BY query_duration_ms DESC LIMIT 10;

데이터 불균형 해결

샤드별 데이터 크기 확인

SELECT hostName() as shard, database, table, formatReadableSize(sum(bytes_on_disk)) as size_on_disk, sum(rows) as total_rows, count() as part_count FROM system.parts WHERE database = 'ecommerce' AND table = 'orders_replica' AND active = 1 GROUP BY hostName(), database, table ORDER BY sum(bytes_on_disk) DESC;파티션별 데이터 분포

SELECT partition, hostName() as shard, sum(rows) as rows_count, formatReadableSize(sum(bytes_on_disk)) as partition_size FROM system.parts WHERE database = 'ecommerce' AND table = 'orders_replica' AND active = 1 GROUP BY partition, hostName() ORDER BY partition, hostName();불균형 해결 방법

- 샤딩 키 변경 (심각한 불균형 시)

- 데이터 재분산 (신중하게)

클러스터 환경에서의 MaterializedView 구성

- ReplicatedSummingMergeTree 활용

-- 실시간 집계 테이블 생성 CREATE TABLE orders.order_stats_realtime ON CLUSTER orders_cluster ( stat_date Date, status Enum8('pending' = 1, 'completed' = 2, 'cancelled' = 3), total_orders UInt32, total_amount UInt64, avg_amount Float32 ) ENGINE = ReplicatedSummingMergeTree('/clickhouse/tables/{shard}/order_stats', '{replica}') ORDER BY (stat_date, status) PARTITION BY toYYYYMM(stat_date);- SummingMergeTree의 핵심 동작

- 동일한

ORDER BY키를 가진 행들의 숫자 컬럼을 자동 합계 - 같은 키의 여러 행을 하나로 병합하여 저장 공간 최적화

- 백그라운드 병합 시 자동으로 합산 실행

- 동일한

- SummingMergeTree의 핵심 동작

- MaterializedView 생성

-- 실시간 집계 MaterializedView CREATE MATERIALIZED VIEW orders.mv_order_stats ON CLUSTER orders_cluster TO orders.order_stats_realtime AS SELECT toDate(order_date) AS stat_date, status, 1 AS total_orders, amount AS total_amount, amount AS avg_amount FROM orders.orders_replica;동작 원리

orders_replica에 새 데이터 INSERT- MaterializedView가 자동으로 트리거

- 변환된 데이터가

order_stats_realtime에 저장 - SummingMergeTree가 자동으로 집계 수행

- 즉, 원본 테이블에 INSERT 시 자동으로 MaterializedView의 SELECT 쿼리가 실행되어 집계 테이블에 데이터 추가한다

증분 업데이트와 데이터 일관성

증분 처리의 핵심

- 새로 들어오는 데이터만 처리하여 성능 최적화